Newsmeldung von slashCAM:

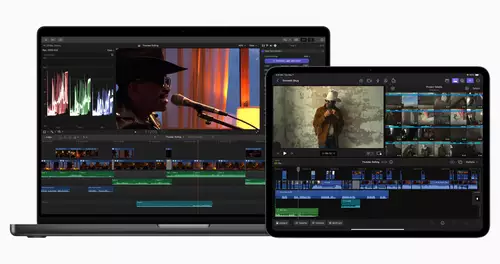

Apple hat heute gleich eine Palette neuer Macs vorgestellt. Einmal zwei Mac Mini Serien mit M2 und M2 Pro. Und dazu zwei neue MacBook Pro Serien mit M2 Pro und M2 Max.

...

Hier geht es zur Newsmeldung auf den slashCAM Magazin-Seiten:

Hier geht es zur Newsmeldung auf den slashCAM Magazin-Seiten:

Neue Apple Mac mini und MacBook Pro Modelle mit M2, M2 Pro und M2 Max

Antwort von Axel:

Eigentlich nur kleine Updates, aber immerhin (zumindest beim Mini) keine höheren Preise. Der Mini Pro dürfte dem Studio Pro in‘s Gehege kommen, preislich ja auch. Ich tippe darauf, dass nach wie vor das kleinere Modell mit 16GB der sweet spot ist.

Antwort von Magnetic:

Bei den Macbook Pros ist der Preis aber auch ordentlich gestiegen.

Antwort von Frank Glencairn:

Wobei man der Fairness halber sagen muß, daß Win-Laptops in der Leistungsklasse jetzt auch nicht wirklich billiger sind.

Antwort von Magnetic:

Bitte nicht die alte MAC / PC Diskussion. :-)

Wenn man sich hier die Leistungsvergleiche (unter der Final Cut Darstellung) anschaut:

https://www.apple.com/de/macbook-pro-14-and-16/

Könnte sich für einige lohnen, sich den M1 Max zu kaufen (sofern man die andere neuen Features nicht braucht) - den gibt es ja ab und zu im Angebot.

Antwort von markusG:

"Frank Glencairn" hat geschrieben:

Wobei man der Fairness halber sagen muß, daß Win-Laptops in der Leistungsklasse jetzt auch nicht wirklich billiger sind.

Wenn es

nur um Leistung geht stimmt das nicht pauschal. Ein Gigabyte Aorus (mit i9-12900HX, 32GB RAM, 1TB SSD, GeForce RTX 3070 Ti) ist ungefähr gleichauf mit einem MBP M1 Max, kostet aber 3200€ (vs 2400€), ist also ~33% teurer bei gleicher Performance.

Wenn es aber um Akkulaufzeit, Bildschirmqualität, Lautsprecherqualität, Verarbeitungsqualität....also eigentlich ziemlich alles andere geht, ist imho nach wie vor kein Laptop direkt vergleichbar, auch ein Dell XPS nicht (der dann tatsächlich das gleiche kostet wie ein MBP).

Antwort von andieymi:

Preis-Leistung stimmt da im Moment immer noch, ich seh's auch so. Es gibt einfach in Summe wenig Anreiz, sich einen Windwos-Laptop zu holen, quasi ALLES andere spricht für Apple. Außer man braucht zwingend Windows.

Antwort von markusG:

andieymi hat geschrieben:

Außer man braucht zwingend Windows.

...oder CUDA/OptiX

Antwort von rush:

andieymi hat geschrieben:

Preis-Leistung stimmt da im Moment immer noch, ich seh's auch so. Es gibt einfach in Summe wenig Anreiz, sich einen Windwos-Laptop zu holen, quasi ALLES andere spricht für Apple. Außer man braucht zwingend Windows.

Wird Zeit das die Gaming Industrie das langsam auch mal erkennt - denn mit den vielen Grafikkernen von Pro und Max sollte sich das doch eigentlich auch für die Entwickler lohnen hin und wieder eine Mac Version zu bringen.

Ich zocke tatsächlich kaum bis gar nicht mehr - aber eine etwas größere Auswahl an MacOS fähigen modernen Games fänd ich dennoch cool - denn meine Steam Bilbiothek als Beispiel enthält kaum MacOS fähige Titel.

Ansonsten sanfte und erwartbare Upgrades... da macht Apple vieles richtig und schraubt an den richtigen Stellen.

M1 Nutzer werden den M2 aber womöglich "skippen" - die Vorteile sind zwar sicherlich vorhanden, aber dürften viele auch mit M1 Pro/Max noch nicht ans Limit bringen, schon gar nicht bei nativer Software wie FCP.

Ich selbst bleibe dem Air M1 weiterhin "treu" - auch wenn die neuen 14"er mit der besseren Portvielfalt schon eine schöne Entwicklung darstellen. Schön das Apple hier nicht wieder Anschlüsse wegrationalisiert hat sondern alle Ports des Vorgängers belässt.

Eines Tages könnte das durchaus ein Upgrade Pfad für mich werden...

Antwort von MarcusG:

Das Problem sind Dinge die eine starke Grafikkarte brauchen. Bei Fusion dropped das bei Macs ganz schnell unter 3fps schon bei einfachsten Sachen, während der reine Schnitt beim M1 viel schneller beim Scrubben flutscht als Intel CPUs.

Da reden wir von einer Grafikleistung von 5TFlops vs 25-80 TFlops bei verschiedenen besseren Grafikkarten

Antwort von rush:

MarcusG hat geschrieben:

Das Problem sind Dinge die eine starke Grafikkarte brauchen. Bei Fusion dropped das bei Macs ganz schnell unter 3fps schon bei einfachsten Sachen, während der reine Schnitt beim M1 viel schneller beim Scrubben flutscht als Intel CPUs.

Da reden wir von einer Grafikleistung von 5TFlops vs 25-80 TFlops bei verschiedenen besseren Grafikkarten

Wo würde sich da ein m2 pro bzw m2 max mit den maximal 38 Grafikkernen ungefähr eingruppieren? Kann man das so grob Richtwerte nennen? Und: kann Resolve bzw. Fusion auch direkt davon profitieren?

Antwort von MarcusG:

Hier eine Demo einer RTX 3090 (35Tflops) vs M1:

Hier eine Tabelle der TFlops Versch. Grafikkarten:

https://www.pc-erfahrung.de/grafikkarte ... liste.html

Der Grafikchip des M2 Max im Vollausbau mit 38 cores wird 13Tflops erreichen, das ist auf dem Niveau einer 2080, was sich gut anhört, aber halt weit hinter aktuellen Grafikkarten liegt und im Preis Richtung 7000€ gehen wird. Für den Preis kann ich Resolve mit 2 Nvidia Grafikkarten nutzen

Antwort von MarcusG:

Hier ist noch ein Clip mit Fusion auf einem 4500 Dollar M1 Max MacBook:

https://m.youtube.com/watch?v=WCab6-2A8sI&t=1120s

Ich hab das Gefühl dass derjenige mit dem Clip den ich zuerst gepostet habe irgendwas falsch gemacht hat. Er hatte wirklich schlechte Performance sogar auf einem i9 mit 3090 das kann nur sein wenn er hält keine Optimierung der Auflösung vornimmt.

Antwort von andieymi:

rush hat geschrieben:

andieymi hat geschrieben:

Preis-Leistung stimmt da im Moment immer noch, ich seh's auch so. Es gibt einfach in Summe wenig Anreiz, sich einen Windwos-Laptop zu holen, quasi ALLES andere spricht für Apple. Außer man braucht zwingend Windows.

Wird Zeit das die Gaming Industrie das langsam auch mal erkennt - denn mit den vielen Grafikkernen von Pro und Max sollte sich das doch eigentlich auch für die Entwickler lohnen hin und wieder eine Mac Version zu bringen.

Ich zocke tatsächlich kaum bis gar nicht mehr - aber eine etwas größere Auswahl an MacOS fähigen modernen Games fänd ich dennoch cool - denn meine Steam Bilbiothek als Beispiel enthält kaum MacOS fähige Titel.

Du sprichst da etwas absolut Wahres an... tatsächlich ist das wohl auch der Grund, warum ich noch keine M1-2 Kiste (neben dem Macbook Air M1 für Office unterwegs) stehen hab, sondern noch den Leistungsstarken Windows-Desktop.

Und was Performance angeht: Ich hab die Dailies von der Venice neulich am Macbook Air M1 gerendert. Klar, das ist kein "Schneiden" aber Scrubbing und Export in Echtzeit von 6K Raw-Footage auf einem Sub-1000€-Brutto-Laptop, was will man mehr. Zeig mir den Windows-Laptop der das kann. Schon klar, die geballte Performance (Grading mit 15 Nodes, 2 Plugins und Denoising) profiziert immer noch extrem von dezidierter GPU-Leistung (und da mehr NVidia, als AMD überhaupt) oder gar 3D - aber für so viele Andwendungszwecke darunter hat Apple mittlerweile die (neben allen Vorteilen wie Design, Verarbeitung, Wertstabilität) preisgünstigeren, performanteren Optionen wie Windows. Niemand bruacht heute mehr eine 700-1500€€ GPU für halbwegs serious Photoshop, ein wenig ProRes schneiden, das geht selbst mit Basis M1.

Wäre ich Fotograf oder würde halt hauptsächlich selber Schneiden, nicht viel mehr als LUT drüber und ein paar Korrekturen - viel ProRes, ProResRaw und nicht viel über 4K, da hätte Apple für jede Preisklasse mittlerweile was Tolles am Start.

Aber bei Games sieht's echt düster aus noch.

Antwort von Funless:

andieymi hat geschrieben:

Wäre ich Fotograf oder würde halt hauptsächlich selber Schneiden, nicht viel mehr als LUT drüber und ein paar Korrekturen - viel ProRes, ProResRaw und nicht viel über 4K, da hätte Apple für jede Preisklasse mittlerweile was Tolles am Start.

Fotograf bin ich zwar nicht aber bei allem anderen passt das schon ganz gut zu meinem persönlichen Use-Case und da bin ich mit meinem MB Air M1 sowas von zufrieden. Also volle Zustimmung was das betrifft.

andieymi hat geschrieben:

Aber bei Games sieht's echt düster aus noch.

Dafür habe ich dann meine Xbox Series X.

Antwort von markusG:

andieymi hat geschrieben:

Aber bei Games sieht's echt düster aus noch.

Und jetzt nicht nur in punkto selber zocken, sondern auch selber produzieren. Da geht es nicht Mal "nur" um Performance, sondern auch sowas wie Feature Parität, oder auch Stabilität.

Wie bei allem: horses for courses.

Antwort von rush:

Funless hat geschrieben:

andieymi hat geschrieben:

Aber bei Games sieht's echt düster aus noch.

Dafür habe ich dann meine Xbox Series X.

Bis auf Sport und Rennspiele oder 'nen Jump&Run kann ich an der Konsole (Series S in meinem Fall) einfach nichts gescheit zocken... Vllt noch den FluSim - aber alles was in Richtung Shooter/Open World oder gar Strategie/Aufbau geht - no chance. Da biege ich mir einen ab - zumindest mit den normalen Konsolen-Controllern sehe ich da kein Land.

Für Tastatur und Maus ist aufm Sofa irgendwie kein Platz - also keine wirkliche Alternative, zumal viele Games solch Eingabegeräte zusätzlich gar nicht erst zulassen.

Wie gesagt - für mich ist das momentan keine wirkliche Priorität mehr, aber so ganz verstehe ich nicht warum nur so wenige Titel für MacOS erscheinen bei der scheinbar sehr fähigen Hardware.

Teilweise kann man ja mittlerweile auf Cloud Gaming zurückgreifen - aber perfekt ist das leider noch immer nicht, schon gar nicht in deutschen Hotels.

Antwort von Funless:

rush hat geschrieben:

Funless hat geschrieben:

Dafür habe ich dann meine Xbox Series X.

Bis auf Sport und Rennspiele oder 'nen Jump&Run kann ich an der Konsole (Series S in meinem Fall) einfach nichts gescheit zocken... Vllt noch den FluSim - aber alles was in Richtung Shooter/Open World oder gar Strategie/Aufbau geht - no chance. Da biege ich mir einen ab - zumindest mit den normalen Konsolen-Controllern sehe ich da kein Land.

Für Tastatur und Maus ist aufm Sofa irgendwie kein Platz - also keine wirkliche Alternative, zumal viele Games solch Eingabegeräte zusätzlich gar nicht erst zulassen.

Tja … und bei mir ist es genau umgekehrt. Seit 1979 spiele ich ausschließlich an Konsolen (fast alle möglichen Genres, inkl. FPS und TPS) und an einem Schreibtisch sitzend, vor dem Computerbildschirm gebeugt und mit Keyboard und Maus hantierend kann ich wiederum nix anfangen. Hab‘s mal vor 15 Jahren versucht, war ein einziger Krampf. Was ich damit sagen will: Es gibt kein pauschales am PC oder an der Konsole wäre es besser. Ist immer individuell abhängig gemäß der persönlichen Präferenzen eines jeden einzelnen.

rush hat geschrieben:

Wie gesagt - für mich ist das momentan keine wirkliche Priorität mehr, aber so ganz verstehe ich nicht warum nur so wenige Titel für MacOS erscheinen bei der scheinbar sehr fähigen Hardware.

Games auf Mac war doch schon immer ein von Apple oder von der Games Industrie (je nachdem von welcher Perspektive man es betrachtet) stiefmütterlich behandeltes Thema. Ich wüßte gar nicht wann das jemals anders war.

Antwort von rush:

Ich habe das Gaming Thema daher ja auch auf mich bezogen - das war keine pauschale Aussage.

Und das "Games" bei Apple eher stiefmütterlich behandelt wurden ist sicherlich kein wirkliches Geheimnis.

Die Frage die ich mir jedoch stelle: Warum eigentlich? Insbesondere mit den neuen potenten Maschinen sollte die Leistung doch locker vorhanden sein und auch ein gewisses Potential an Kunden sollte vorhanden sein.

Was schreckt die Programmierer/Studios/Publisher also ab auch parallel oder gar exklusiv für MacOS zu entwickeln?

Das ganze allein aus historischen Gründen zu erklären erscheint mir etwas zu einfach. Führt aber vielleicht auch zu weit- Als langjähriger Win-Nutzer klafft in diesem Bereich durchaus eine spürbare Lücke die mir aber bewusst gewesen ist und mit der ich leben kann.

Falls sich dahingehend aber etwas mehr bewegen sollte, würde ich das durchaus begrüßen.

Antwort von DKPost:

rush hat geschrieben:

Ich habe das Gaming Thema daher ja auch auf mich bezogen - das war keine pauschale Aussage.

Und das "Games" bei Apple eher stiefmütterlich behandelt wurden ist sicherlich kein wirkliches Geheimnis.

Die Frage die ich mir jedoch stelle: Warum eigentlich? Insbesondere mit den neuen potenten Maschinen sollte die Leistung doch locker vorhanden sein und auch ein gewisses Potential an Kunden sollte vorhanden sein.

Was schreckt die Programmierer/Studios/Publisher also ab auch parallel oder gar exklusiv für MacOS zu entwickeln?

Das ganze allein aus historischen Gründen zu erklären erscheint mir etwas zu einfach. Führt aber vielleicht auch zu weit- Als langjähriger Win-Nutzer klafft in diesem Bereich durchaus eine spürbare Lücke die mir aber bewusst gewesen ist und mit der ich leben kann.

Falls sich dahingehend aber etwas mehr bewegen sollte, würde ich das durchaus begrüßen.

Ich bin mir ziemlich sicher, dass moderne Spiele nicht einfach auf die Mac-Architektur portiert werden können. Das ist ja bei PC und Konsolen schon ein riesiger und teurer Aufwand. Und bei der kleinen Zielgruppe der Gamer auf Macs wird sich das einfach Null lohnen.

Weiter ist die Architektur auch einfach so unterschiedlich und viele Features von modernen Engines wie z.B. Raytracing so stark auf Nvidia oder AMD ausgelegt, dass man da vieles wahrscheinlich garnicht portieren kann.

Einige essentielle Features z.B. der Unreal Engine zum erstellen von Content laufen wohl auch nicht auf Mac.

Antwort von rush:

Diesem Artikel nach (aus Mitte 2022) ein typisches Henne-Ei-Problem wenn man so will...

"Jahrelang waren die Mac-Entwickler zudem in einer negativen Rückkopplungsschleife gefangen: Apple unterstützte die Spielentwicklung aufgrund zu kleiner Zielgruppen, fehlendem Entwickler-Support und Mangel an Unterstützung sowie Tools nicht, während die Spieler keine Macs kauften, da es schlicht zu wenig Titel gab, die man darauf zocken konnte. "

https://global.techradar.com/de-de/news ... rsprechend

Schau'n wir mal ob da perspektivisch was geht.

Antwort von DKPost:

rush hat geschrieben:

Diesem Artikel nach (aus Mitte 2022) ein typisches Henne-Ei-Problem wenn man so will...

"Jahrelang waren die Mac-Entwickler zudem in einer negativen Rückkopplungsschleife gefangen: Apple unterstützte die Spielentwicklung aufgrund zu kleiner Zielgruppen, fehlendem Entwickler-Support und Mangel an Unterstützung sowie Tools nicht, während die Spieler keine Macs kauften, da es schlicht zu wenig Titel gab, die man darauf zocken konnte. "

https://global.techradar.com/de-de/news ... rsprechend

Schau'n wir mal ob da perspektivisch was geht.

Ich glaube eher, dass das noch unwahrscheinlicher wird. Die M-Chips haben z.B. keine RT Cores wie die NVidia GPUs. Und da das das neue heiße Feature im Gaming ist wird alles darauf optimiert. Und selbst die dedizierten GPUs gehen da in die Knie.

Das heißt natürlich nicht, dass die M-Chips generell kein RT rechnen können, aber die Engines werden eben nicht darauf optimiert weil Kosten/Nutzen da in keinem Verhältnis steht. Ich bin da aber auch kein Experte, ist nur meine Einschätzung

Antwort von andieymi:

Das driftet jetzt fast in eine Richtung ab, wo Gaming der große Kritikpunkt an den neuen Macs ist.

Aber MarkusG hat schon Recht, für - aber das sind halt auch wirklich oft Spezialanwendungen - wenn ich professioneller Motion Designer / 3D / VFX Artist bin, würde ich mir das mit dem Mac noch mal überlegen, aber für quasi jeden anderen (Fotograf, Creator, Videojournalist, Industriefilmer, ...) bietet der neue M2 Pro vermutlich fast alles.

Andererseits ist die Frage, wohin die Reise noch geht. Die Entwicklungen beim M2 waren ja jetzt so nuanciert, weil eigentlich die M1 schon sehr viel richtig gemacht haben. Da wäre auch noch der Platz für einen "Technologiesprung" (RT-Cores?), wobei der halt auch die Grundlage für M1 eigentlich schon war, wieso sie quasi alles im Intel-Mobilbereich mit Rechenleistung/Watt auch abhängen. AI-Upscaling (ich erinnere mich an den anderen Thread) scheint M2 ja jetzt auch zu beherrschen, was meines Erachtens nach eine der Schlüsseltechnologien für Games in den nächsten 10 Jahren sein wird, wenn man sich die aktuellen GPU Entwicklungen anschaut. Wer weiß, was da noch kommt.

Antwort von DKPost:

andieymi hat geschrieben:

Das driftet jetzt fast in eine Richtung ab, wo Gaming der große Kritikpunkt an den neuen Macs ist.

Aber MarkusG hat schon Recht, für - aber das sind halt auch wirklich oft Spezialanwendungen - wenn ich professioneller Motion Designer / 3D / VFX Artist bin, würde ich mir das mit dem Mac noch mal überlegen, aber für quasi jeden anderen (Fotograf, Creator, Videojournalist, Industriefilmer, ...) bietet der neue M2 Pro vermutlich fast alles.

Andererseits ist die Frage, wohin die Reise noch geht. Die Entwicklungen beim M2 waren ja jetzt so nuanciert, weil eigentlich die M1 schon sehr viel richtig gemacht haben. Da wäre auch noch der Platz für einen "Technologiesprung" (RT-Cores?), wobei der halt auch die Grundlage für M1 eigentlich schon war, wieso sie quasi alles im Intel-Mobilbereich mit Rechenleistung/Watt auch abhängen. AI-Upscaling (ich erinnere mich an den anderen Thread) scheint M2 ja jetzt auch zu beherrschen, was meines Erachtens nach eine der Schlüsseltechnologien für Games in den nächsten 10 Jahren sein wird, wenn man sich die aktuellen GPU Entwicklungen anschaut. Wer weiß, was da noch kommt.

Ich habe auch schon die Vermutung gelesen, dass die M-Chips in Zukunft RT-Cores bekommen könnten.

Die Unreal Engine soll laut Epic in Zukunft auch nativ auf den Macs laufen, und die Beleuchtungstechnologie Lumen läuft wohl seit kurzem auch, aber eben ohne RT-Cores recht langsam. Aber immerhin, bis vor kurzem ging es garnicht. Nanite, was wohl auch ein recht essentielles Tool für Games-Designer ist, läuft aber derzeit wohl noch nicht.

Antwort von Darth Schneider:

Krass bei Apple finde ich ist ja jetzt:

Das in dem iPad Air mit nur 8Giga RAM, das ich jetzt habe, Resolve ja auch schon mit 4K eigentlich ohne Probleme funtzt und das Material viel flüssiger abspielt und viel schneller rechnet wie mein iMac;)))

Wohin führt diese Entwicklung ?

Also ich selber weiss noch überhaupt nicht ob ich meinen iMac durch einen neuen Mac Mini oder einen iMac mit M2 ersetzen werde, oder ob ich mir dann einfach ein grosses iPad Pro nehme mit dem M2 drin.

Gruss Boris

Antwort von rush:

andieymi hat geschrieben:

Das driftet jetzt fast in eine Richtung ab, wo Gaming der große Kritikpunkt an den neuen Macs ist.

So war das eigentlich nicht gemeint, auch weil das ja so gesehen nichts Neues ist.

Sondern eher in der Form, als das hier sicher noch Potential in den hochgerüsteten M2ern steckt welches eben auch für Gaming und ähnliche Anwendungen interessant sein könnte. Was sie (Apple, Entwickler, Hersteller und Co) daraus machen steht auf einem anderen Blatt Papier.

Antwort von Funless:

rush hat geschrieben:

andieymi hat geschrieben:

Das driftet jetzt fast in eine Richtung ab, wo Gaming der große Kritikpunkt an den neuen Macs ist.

So war das eigentlich nicht gemeint, auch weil das ja so gesehen nichts Neues ist.

Sondern eher in der Form, als das hier sicher noch Potential in den hochgerüsteten M2ern steckt welches eben auch für Gaming und ähnliche Anwendungen interessant sein könnte. Was sie (Apple, Entwickler, Hersteller und Co) daraus machen steht auf einem anderen Blatt Papier.

Letztendlich ist es ja so wie in dem von dir verlinkten Artikel. Alles eine Frage der Wirtschaftlichkeit.

Ein sog. "AAA-Game" kostet mitllerweile in der Entwicklung (Scratch to Release) mehr als die Produktion eines Blockbuster Films (spielt allerdings auch ein vielfacheres an Umsatz ein als ein Blockbuster Film) und die absolute Anzahl von potenziellen Gamern auf Mac ist im Vergleich zu den Gamern auf PC und Konsole verschwindend gering, so dass es für die Entwickler und Publisher (zweitgenannte sind es übrigens den Großteil der Entwicklungskosten aufbringen, vergleichbar mit Produktionsfirma bei Film) ein zu hohes Risiko darstellt, dass am Ende der Aúfwand die die Entwicklung/Portierung für Mac höher ausfällt als der Ertrag. Von daher wird es meistens gar nicht erst angegangen. Klar ist es zwar schade aber ist eben leider so.

Antwort von andieymi:

Funless hat geschrieben:

Letztendlich ist es ja so wie in dem von dir verlinkten Artikel. Alles eine Frage der Wirtschaftlichkeit.

Ein sog. "AAA-Game" kostet mitllerweile in der Entwicklung (Scratch to Release) mehr als die Produktion eines Blockbuster Films (spielt allerdings auch ein vielfacheres an Umsatz ein als ein Blockbuster Film) und die absolute Anzahl von potenziellen Gamern auf Mac ist im Vergleich zu den Gamern auf PC und Konsole verschwindend gering, so dass es für die Entwickler und Publisher (zweitgenannte sind es übrigens den Großteil der Entwicklungskosten aufbringen, vergleichbar mit Produktionsfirma bei Film) ein zu hohes Risiko darstellt, dass am Ende der Aúfwand die die Entwicklung/Portierung für Mac höher ausfällt als der Ertrag. Von daher wird es meistens gar nicht erst angegangen. Klar ist es zwar schade aber ist eben leider so.

Eben da frag ich mich, ob Apple wirklich auf den Markt verzichten kann.

Ich hab neulich gelesen Gaming war 2022 so groß wie die globale Film + Musikindustrie kombiniert. Nachdem Leute, die mit dem aufgewachsen sind "mitwachsen" (bin jetzt 31), und gleichzeitig neue Gamer nachkommen, wird der Markt auch noch weiter wachsen.

Ob Apple das wirklich Microsoft überlassen will, wage ich eigentlich zu bezweifeln.

Antwort von Funless:

Klar, theoretisch könnte Apple einen oder sogar zwei der großen "AAA"-Publisher aufkaufen, wahrscheinlich sogar nur aus ihrer Portokasse. Aber damit wäre es ja nicht getan. Ich kenne mich zwar nicht gut genug mit der Materie der Games Entwicklung aus, doch ich vermute, dass ja dann noch bei der Entwicklung/Portierung eine ganze Menge an Invest nötig wäre, andererseits würde sie ja dann auch beim Kauf eines AAA-Publishers von den Erträgen aus PC und Konsole partizipieren.

Wie gesagt, meine Expertise reicht da leider nicht um diesbezüglich eine sinnvolle Aussage zu treffen.

Antwort von andieymi:

Funless hat geschrieben:

Klar, theoretisch könnte Apple einen oder sogar zwei der großen "AAA"-Publisher aufkaufen, wahrscheinlich sogar nur aus ihrer Portokasse. Aber damit wäre es ja nicht getan. Ich kenne mich zwar nicht gut genug mit der Materie der Games Entwicklung aus, doch ich vermute, dass ja dann noch bei der Entwicklung/Portierung eine ganze Menge an Invest nötig wäre, andererseits würde sie ja dann auch beim Kauf eines AAA-Publishers von den Erträgen aus PC und Konsole partizipieren.

Wie gesagt, meine Expertise reicht da leider nicht um diesbezüglich eine sinnvolle Aussage zu treffen.

Ich auch nicht, aber wenn man sich den Gaming Markt anschaut, dann gibt's da dann auch wieder (abgesehen von 10000 Indies) gar nicht mehr so viele AAA-Publisher. Activison, EA, Epic? Microsoft will ja jetzt Activision kaufen, wäre doch eine Treppenwitz der Geschichte, wenn sich Apple nach den Streitereien wegen dem AppStore und Fortnite jetzt Epic holt. Aber je länger ich darüber nachdenke, eigentlich würde Epic sogar 1A zur Apple-DNA passen: Mobil-fokussiert, kreative Mitnutzung von Unreal Engine, viel diverser aufgestellt als z.B. Activision.

Antwort von Funless:

Naja es gäbe u.a. noch Take 2 Interactive die sich mit Rockstar Games einen (oder ich behaupte sogar

den) Umsatz-und-Gewinn-Goldesel herangezüchtet haben.

Aber ich sehe das schon ähnlich wie du. Weshalb Apple da nicht tiefer einsteigt bleibt wohl ein Geheimnis welches höchstens nur Tim Cook lüften könnte.

Antwort von cantsin:

Funless hat geschrieben:

Aber ich sehe das schon ähnlich wie du. Weshalb Apple da nicht tiefer einsteigt bleibt wohl ein Geheimnis welches höchstens nur Tim Cook lüften könnte.

Die werden sicher Marktforschung gemacht haben und zum Schluss gekommen sein, dass die typische Gamer-Demografie sich kaum oder zu wenig mit der Apple Mac-Zielgruppe überschneidet. Das ist ja ähnlich wie bei der Zielgruppe eines Toyota Prius ggü. der Zielgruppe eines getunten Golf GTI.

PC-Gamer würde Ansprüche an Apples Hardwareentwickelung stellen, denen sich die Firma wohl kaum aussetzen möchte, selbst bei so banalen Dingen wie z.B. Bildschirmwiederholraten. Und die 'casual gamers' werden bereits auf iOS bedient.

Antwort von DKPost:

andieymi hat geschrieben:

Funless hat geschrieben:

Klar, theoretisch könnte Apple einen oder sogar zwei der großen "AAA"-Publisher aufkaufen, wahrscheinlich sogar nur aus ihrer Portokasse. Aber damit wäre es ja nicht getan. Ich kenne mich zwar nicht gut genug mit der Materie der Games Entwicklung aus, doch ich vermute, dass ja dann noch bei der Entwicklung/Portierung eine ganze Menge an Invest nötig wäre, andererseits würde sie ja dann auch beim Kauf eines AAA-Publishers von den Erträgen aus PC und Konsole partizipieren.

Wie gesagt, meine Expertise reicht da leider nicht um diesbezüglich eine sinnvolle Aussage zu treffen.

Ich auch nicht, aber wenn man sich den Gaming Markt anschaut, dann gibt's da dann auch wieder (abgesehen von 10000 Indies) gar nicht mehr so viele AAA-Publisher. Activison, EA, Epic? Microsoft will ja jetzt Activision kaufen, wäre doch eine Treppenwitz der Geschichte, wenn sich Apple nach den Streitereien wegen dem AppStore und Fortnite jetzt Epic holt. Aber je länger ich darüber nachdenke, eigentlich würde Epic sogar 1A zur Apple-DNA passen: Mobil-fokussiert, kreative Mitnutzung von Unreal Engine, viel diverser aufgestellt als z.B. Activision.

Da gibt es schon noch einige Schwergewichte. Microsoft und Sony sind selbst Publisher, Ubisoft, Bethesda (gehört mitllerweile zu Microsoft), Blizzard, Konami, Nintendo würden mir spontan einfallen.

Antwort von andieymi:

DKPost hat geschrieben:

Da gibt es schon noch einige Schwergewichte. Microsoft und Sony sind selbst Publisher, Ubisoft, Bethesda (gehört mitllerweile zu Microsoft), Blizzard, Konami, Nintendo würden mir spontan einfallen.

Und keinen will / kann sich Apple leisten?

Aber da gab es scheinmal wirklich zumindest schon mal Berührungspunkte:

https://9to5mac.com/2022/05/23/apple-ea-in-talks/

Ich sehe das Problem eher dabei, dass viele Große einfach dann doch nur wenige exklusive Titelreihen haben, wo allerdings auch nur alle paar Jahre mal ein AAA-Title rauskommt. Rockstar (Published ja auch selbst), Bethesda, z.B.

Ein Witcher 4, Elder Scrolls X oder GTA wäre schon gut für Apple, aber das sichert ihnen langfristig nicht den Fuß in der Tür für verschiedene Gaming-Zielgruppen. Wenn ich da keine Rollenspiele mag, kauf ich mir trotzdem keinen Mac zum Zocken.

Wohingegen EA, wenn man da alles mit Sport, Need for Speed, Shooter (Battlefield, Apex), Sims, Star Wars nimmt - damit wären sie im Zentrum des Videospielmarktes und könnten zig Zielgruppen bedienen. Selbst Ubisoft würe schon helfen, auch wenn deren Spiele mittlerweile oft wie "Ubisoft-Spiele" (Copy-Paste) wirken, die Bandbreite wäre da (vgl. mit Rockstar oder Bethesda).

Antwort von markusG:

andieymi hat geschrieben:

aber das sind halt auch wirklich oft Spezialanwendungen - wenn ich professioneller Motion Designer / 3D / VFX Artist bin, würde ich mir das mit dem Mac noch mal überlegen

Finde ich schon gewagt das als Spezialanwendungen zu bezeichnen, in Hinblick darauf wo Apple mal war...schade eigentlich, dass das scheinbar keine (ausreichend große) Rolle mehr spielt. Der Zug ist abgefahren und muss erst einmal wieder eingeholt werden.

rush hat geschrieben:

Diesem Artikel nach (aus Mitte 2022) ein typisches Henne-Ei-Problem wenn man so will...

Ironischerweise hat es für Linux geklappt, nicht zuletzt noch durch Valve's Steam Deck...dabei ist der Marktanteil wesentlich kleiner. Dafür ist Linux die Antithese zum walled garden...

Antwort von rush:

cantsin hat geschrieben:

Die werden sicher Marktforschung gemacht haben und zum Schluss gekommen sein, dass die typische Gamer-Demografie sich kaum oder zu wenig mit der Apple Mac-Zielgruppe überschneidet. Das ist ja ähnlich wie bei der Zielgruppe eines Toyota Prius ggü. der Zielgruppe eines getunten Golf GTI.

Aber genau diese Einstellung ist doch eigentlich paradox.

Warum darf oder sollte es hier denn keine Schnittmenge geben?

Wieviele Leute in meinem Freundeskreis sind früher gerne 'nen heißen Hobel gefahren oder haben sich wenig für Benzinverbräuche und dergleichen interessiert. Mit den Jahren wandelt sich sowas aber sehr häufig, es kommen Familien hinzu, die globale Situation ist heute eine andere und plötzlich spielen auch ganz andere Parameter - mindestens subtil eine Rolle. Da wird dann schon mehr auf die Effizienz Wert gelegt - und dennoch möchte man sich an der Auffahrt zügig einfädeln oder auch etwas flotter reisen wenn es der Verkehr erlaubt.

Die neuen M2er in den höheren Ausbaustufen bieten doch auf dem Papier genau diese Symbiose - sprich leise, effiziente "Cruising-Möglichkeiten" bishin zu absurd hoher Performance wenn die Software darauf optimiert und ausgelegt ist = best of both world's.

Ein Prius mit Turbo-Punch Modus anstatt nur dem ECO-Mode könnte sicherlich vielen "Mid-Agern" durchaus taugen - wenn wir das Design der letzteren Prius-Zyklen mal außen vor lassen. Da bekommt die Hybrid Bedeutung doch nochmals einen doppeldeutigen Sinn.

So gesehen wäre ein M2 Pro/Max mit solider Gaming-Unterstützung durchaus eine angenehme Ergänzung - besonders auch für "ehemalige" Gamer die aus Produktivitätsgründen auf MacOS unterwegs sind. Mit dem M1 und nachfolgenden haben sie doch das Wort Effizienz doch wirklich auf ein neues Level gehoben. Also dürfen sie sich auch gern in Richtung Gaming etwas mehr öffnen - just my 2 cents :-)

Antwort von Darth Schneider:

Da sehe ich ein kleines Detail schon ganz anders.

Doch, ich denke eben genau mit dem M1 Chip hat Apple die Effizienz auf ein ganz neues Level gehoben.

Weil wenn das nicht so wäre dann würde Da Vinci Resolve kaum laufen auf einem M1 iPad Air.

Das 400€ Ding behaupte ich mal ist schneller als so manches 1500€ Notebook…

Die Windows und Android Konkurrenz schläft halt inzwischen immer noch tief..

Gruss Boris

Antwort von DKPost:

"Darth Schneider" hat geschrieben:

Da sehe ich ein kleines Detail schon ganz anders.

Doch, ich denke eben genau mit dem M1 Chip hat Apple die Effizienz auf ein ganz neues Level gehoben.

Weil wenn das nicht so wäre dann würde Da Vinci Resolve kaum laufen auf einem M1 iPad Air.

Die Windows und Android Konkurrenz schläft inzwischen immer noch tief..

Gruss Boris

Gamer interessieren sich in der Regel aber nicht für Effizienz, sondern für brachiale Rechenpower. Und da kommen die M-Chips nicht an dedizierte GPUs ran. An die neue 40er Serie von NVidia schon garnicht.

Ich wäre ja extrem gespannt auf den M2 Extreme gewesen, aber scheinbar entwickelt Apple den nun doch nicht.

Antwort von Darth Schneider:

Nun ja Apple war doch nie so der Gaming Spezialist, zumal In 10 Jahren laden die Gamer dann nur noch antike Spiele überhaupt auf ihre Rechner.

Rechnen tun dann nur noch die Server der Hersteller und Betreiber, mit der KI…

Apple weiss das womöglich…

Gruss Boris

Antwort von DKPost:

"Darth Schneider" hat geschrieben:

Nun ja Apple war doch nie so der Gaming Spezialist, zumal In 10 Jahren laden die Gamer dann nur noch antike Spiele überhaupt auf ihre Rechner.

Apple weiss das womöglich…

Gruss Boris

Einmal hat Apple den Einstieg ja schonmal versucht:

https://de.wikipedia.org/wiki/Apple_Pippin

Antwort von Paralkar:

Unabhängig von Cyberpunk auf bester Grafik mit Raytraycing, es gebe soviel andere Games die trotz "Emulation" via Parallels oder Crossover fl?ssig laufen. Nativ müsste dann gta5 locker auf dem M1 Max laufen.

Aber da passiert nix, trotz dem Wechsel auf ARM, find ich schon sehr schade, bin zu Cloud Gaming übergegangen, um mal so ein AAA Titel in voller Bracht zu spielen.

Ich denke Apple hat schon lange begriffen, daß meiste Geld is im Mobile Gaming zu holen, sowas wie Call of Duty fürs Handy und Tablet bringt bei vergleichweise überschaubaren Entwicklungsaufwand unfassbar viel Geld, oder pay to win Games wie Diablo Immortal etc. (da wird sicher auch recycelt was geht)

Und da liefert ja Apple vernünftige Geräte.

Dank dieser Entwicklung haben wir jetzt 50W Notebooks die bei 35 Grad im schwarzen Zelt, durchgehend 6k XOCN ST mit 60 fps rendern.

Der m2 pro soll cpu-seitig den M1 Max in Single & Multicore Performance schlagen. Ich muss mich bis auf wenige Ausnahmen wie Noise Reduction und diverse Open FX Plugins fragen, was bringt mir die Mehrleistung? Bei gewissen Aufgaben ist jetzt die Datenanbindung das Problem, 10 gbit nvmes lassen mir nicht die Möglichkeit die maximale Rechenleistung zu nutzen, da brauch ich Thunderbolt SSDs, damit ich die 200 fps rendern kann.

Antwort von Darth Schneider:

Also jedenfalls sind 1500 für ein Apple Computer mit M2 Pro Prozessor schon ne echt günstige Ansage..

Wenn man bedenkt wie schnell der normale M1 schon ist…

Ich denke wenn wir mal vom Gamen absehen, hat Apple seit diesen M Chips sehr kräftig gegenüber Microsoft und Co aufgeholt.

Früher (noch nicht lange her) waren Apple Computer jedenfalls immer viel teurer und langsamer, als vergleichbare PCs, heute mit den sehr schnellen und günstigen iPads/MacBooks/iMacs und den ebensolchen Mac Minis ist das eher völlig umgekehrt.

Der Steve Jobs hat schon gewusst warum er den Tim Cook damals schon als die Nr 2 aufgestellt hat…

Ich denke der hat seine Hausaufgaben gemacht..

Go Apple !

Gruss Boris

Antwort von Jott:

Ja, man muss sich schon anstrengen, um ein Haar in der Suppe zu finden. Aber Haar-in-der-Suppe-Finder gibt's immer, weil die Dinger ja von Apple sind.

Antwort von Frank Glencairn:

Jott hat geschrieben:

Ja, man muss sich schon anstrengen, um ein Haar in der Suppe zu finden. Aber Haar-in-der-Suppe-Finder gibt's immer, weil die Dinger ja von Apple sind.

Ja, aber selbst ich, als "Apple Haar Spezialist" tu mich da mittlerweile schwer ;-)

Antwort von Darth Schneider:

Das Dateien Speicher Konzept beim normalen iPad nervt mich irgendwie immer noch….

Aber sonst kann man die Haare in der Apple Suppe, genau so gut auf einem Glatzkopf suchen…;)))

Gruss Boris

Antwort von DKPost:

Jott hat geschrieben:

Ja, man muss sich schon anstrengen, um ein Haar in der Suppe zu finden. Aber Haar-in-der-Suppe-Finder gibt's immer, weil die Dinger ja von Apple sind.

Mein Haar in der Suppe ist leider immernoch die Leistung. So viel Leistung bei so geringem Stromverbrauch ist definitiv eine richtig gute Entwicklung, aber die Dinger sind eben nur so gut wie ein teurer Windows Laptop oder eine etwas in die Tage gekommene Workstation. An die aktuelle High-End Hardware kommt ein MacBook oder ein Studio Mac einfach noch nicht ran.

Deswegen bin ich sehr auf den MacPro oder den Studio Mac mit M2 gespannt. Das könnte das erste Apple-Produkt werden das ich mir jemals kaufe. Aber eben nur wenn die Leistung mindestens auf dem Level der aktuellsten High-End Hardware ist. So geringeren Stromverbrauch hätte ich schon auch gerne, aber nicht auf Kosten meiner Zeit + Produktivität.

Antwort von Jott:

Du hast immer die Wahl. Man wird sich nie etwas kaufen, was einen wegen Obst-Allergie jahrelang jeden Morgen ankotzt! :-)

Bei einem neuen MacPro würde ich prophezeien: wird nix. Sicher hübsch und super schnell, aber viel teurer als die klassische fönende Selbstbau-Workstation. Daher uninteressant für fast jeden, wie bisher auch.

Antwort von DKPost:

Jott hat geschrieben:

Du hast immer die Wahl. Man wird sich nie etwas kaufen, was einen wegen Obst-Allergie jahrelang jeden Morgen ankotzt! :-)

Niemand hat irgendetwas in der Art gesagt.

Antwort von Darth Schneider:

DKPost

Es gibt doch gar keine Spitzenleistung bei Computern ohne grossen Stromverbrauch…Weder bei PCs noch bei Apple…

Und was die Leistung von den M1/M2 Prozessoren betrifft:

Ich bin mir ganz sicher, so ein bis zum geht nicht mehr, aufepppter M1 Max Ultra mit genug RAM, (in einem Mac Studio drin, der so viel kostet wie ein anständiges Auto), kann doch schon heute ganz locker mithalten mit der aktuellen Windows Workstation Konkurrenz.

Kostet dann einfach auch noch mehr….;)

Die M2 Generation wird jedenfalls noch schneller und wird noch weniger Strom fressen…

Gut so…

Gruss Boris

Antwort von markusG:

Jott hat geschrieben:

Du hast immer die Wahl.

In Zeiten von Lieferengpässen ist sowas immer leicht gesagt^^

Ach ja ein Vorteil der nicht-gaming-Orientierung vom MAC: keine Anfälligkeit gegenüber Scalpern B)

"Darth Schneider" hat geschrieben:

Ich denke jedenfalls, so ein bis zum geht nicht mehr, aufepppter M1 Max mit genug RAM, (in einem Mac Studio drin, der so viel kostet wie ein Auto), kann doch schon mithalten mit der aktuellen Windows Konkurrenz.

Gerade da eigentlich eher nicht, da Apple ja die jedes Gramm Aufrüstung einen derart hohen Aufpreis verlangt, gleichzeitig die Leistung aber limitiert ist (Apple arbeitet ja nicht an der Physik vorbei) und bestimmte Schnittstellen verworfen hat, ist man je nach Anwendungsfall nicht mit "je teurer desto besser" gut bedient. Sweet Spot ist die Losung.

Antwort von DKPost:

"Darth Schneider" hat geschrieben:

DKPost

Es gibt doch gar keine Spitzenleistung bei Computern ohne grossen Stromverbrauch…Weder bei PCs noch bei Apple…

Und was die Leistung von den M1/M2 Prozessoren betrifft:

Ich bin mir ganz sicher, so ein bis zum geht nicht mehr, aufepppter M1 Max Ultra mit genug RAM, (in einem Mac Studio drin, der so viel kostet wie ein anständiges Auto), kann doch schon heute ganz locker mithalten mit der aktuellen Windows Workstation Konkurrenz.

Kostet dann einfach auch noch mehr….;)

Die M2 Generation wird jedenfalls noch schneller und wird noch weniger Strom fressen…

Gut so…

Gruss Boris

Ich habe damals zum Release keinen Test zum Studio Mac gesehen der da mithalten konnte. Und seitdem gibt es auch schon wieder neue CPUs und GPUs, der Abstand ist jetzt also noch größer als zum Release.

Wie gesagt, der Studio mit M2 wäre interessant. Mal abwarten was da kommt. Schade, dass es den M2 Extreme nicht geben wird.

Antwort von Darth Schneider:

Also das mit den Anschlüssen bei Apple ist ein grosses Haar in der Suppe und mir ein Rätsel.

Also warum hat ein günstiger Mac Mini viel mehr Anschlüsse, wie ein teures MacBook Pro, oder ein ein iMac ?

Einzig beim Mac Studio haben sie das sonst auch noch konsequent gelöst…

Ansonsten, nur spartanisch, ich verstehe ich die Idee dahinter gar nicht…

Wahrscheinlich hat der Mr Cook eine chronische Allergie gegen Kabel….;))))

Gruss Boris

Antwort von markusG:

"Darth Schneider" hat geschrieben:

Also das mit den Anschlüssen bei Apple ist ein grosses Haar in der Suppe und mir ein Rätsel.

Wenn du das auf meinen Post beziehst: ich bezog mich da auf APIs, nicht physische Schnittstellen am Gerät selbst. Sorry für das Mißverständnis.

Gibt sicher noch den ein oder anderen, der aus Softwaregründen an Intel festhält (Plugins...) oder gar an der alten Käseraspel (Cuda...), auch wenn das imho Grenzfälle darstellen. Der Rest wandert eher ab, siehe 3D...

Wie gesagt: horses for courses.

Antwort von vaio:

"Darth Schneider" hat geschrieben:

Das Dateien Speicher Konzept beim normalen iPad nervt mich irgendwie immer noch….

Gruss Boris

Unter anderem werde ich deshalb zukünftig daheim mit meinem iPad pro auf den bestellten mini M2 pro zugreifen. Dieser kommt Anfang Feb. und ersetzt mein betagtes 15“ mb pro. Für unterwegs reicht mir das ipp.

"Darth Schneider" hat geschrieben:

Also warum hat ein günstiger Mac Mini viel mehr Anschlüsse, wie ein teures MacBook Pro, oder ein ein iMac ?

Gruss Boris

Der mac mini hat kein Display und kein Eingabegerät…😉

Antwort von andieymi:

Jott hat geschrieben:

Bei einem neuen MacPro würde ich prophezeien: wird nix. Sicher hübsch und super schnell, aber viel teurer als die klassische fönende Selbstbau-Workstation. Daher uninteressant für fast jeden, wie bisher auch.

Schwierig, wenn Grafikkarten wo man den Macs langsam die Schneid abkauft bei 1500€ liegen. Im Prinzip hast Du Recht, aber die GPU-Preise machen die Macs wirklich preiswert im Moment. Die Zeiten, wo eine gute CPU 350€, eine sehr gute Grafikkarte 900€ gekostet hat und man für RAM + MB 200€ ausgibt sind halt vorbei.

"Darth Schneider" hat geschrieben:

Also das mit den Anschlüssen bei Apple ist ein grosses Haar in der Suppe und mir ein Rätsel.

Also warum hat ein günstiger Mac Mini viel mehr Anschlüsse, wie ein teures MacBook Pro, oder ein ein iMac ?

Weil Du ab dem Punkt, wo Du mit einem MacBook Pro 4 Festplatten und einen Router mitschleppst, der Monitor und die Tastatur für einen Mac Mini auch schon egal sind.

Und hast Du schon mal mit USB4 gearbeitet? Verglichen mit 3.0 kannst du den Anschluss selbst mit mehreren Drives in asymetrischen Lese/Schreibrichtungen gar nicht mehr so auslasten, dass das der Flaschenhals wird. Hängst Du mittels Adapter 4 HDDS an einen USB4.0 und der Flaschenhals bleiben immer noch die HDDs. Synthetisch geht das bestimmt (Externe NVME-SSD), allerdings kaum praktisch.

Antwort von Darth Schneider:

Hmm.

Alleine für den Strom und die Maus und Tastatur aufzuladen braucht es eigentlich schon zwei Anschlüsse reserviert, und für ein Monitor und eine Ssd wäre ein dritter und vierter USB Anschluss am Computer schon sinnvoll, und nicht zu viel verlangt…

Und zwingend ein Hub ist doch auch nicht alles.

Hinten und vorne und Usb Anschlüsse bei den iMacs und Mac Minis wäre sehr sinnvoll..Und der SD Card Slot (bei allen Rechnern) gefälligst möglichst nach vorne…;))))

Gruss Boris

Antwort von iasi:

"Darth Schneider" hat geschrieben:

Hmm.

Alleine für den Strom und die Maus und Tastatur aufzuladen braucht es eigentlich schon zwei Anschlüsse reserviert, und für ein Monitor und eine Ssd wäre ein dritter und vierter USB Anschluss am Computer schon sinnvoll, und nicht zu viel verlangt…

Und zwingend ein Hub ist doch auch nicht alles.

Hinten und vorne und Usb Anschlüsse bei den iMacs und Mac Minis wäre sehr sinnvoll..Und der SD Card Slot (bei allen Rechnern) gefälligst möglichst nach vorne…;))))

Gruss Boris

Was ich zu Hubs gelesen und gehört habe, ist eher abschreckend.

Apple-Geräte geben sich für meinen Geschmack zu zugeknöpft - sie zu erweitern, geht nur mit Notlösungen.

Antwort von Jott:

„ .., und die Maus und Tastatur aufzuladen braucht es eigentlich schon zwei Anschlüsse“

Du musst doch Maus und Tastatur nicht am Rechner aufladen.

Deswegen an einen Hub denken? Ein Mehrfach-USB-Lader für ein paar Euro in der nächsten Steckdose und gut ist. Also manchmal …

Antwort von rush:

Zumal es mittlerweile auch es gute Funktastaturen und Mäuse gibt die via BT mit dem MacBook kommunizieren... Damit muss man eigentlich keine Ports mehr belegen.

Aber generell bin ich bei Boris - Anschlüsse kann man besonders an Desktop basierten Systemen selten genug haben.

Ich habe am MacBook aktuell zwei kleine Hubs hängen um alle Geräte entsprechend ins System zu bekommen... wirklich elegant ist das nicht und wahrscheinlich teste ich Mal solch einen größeres TB Dock - auch wenn die Preise hierfür teilweise absurd sind im Vergleich zum Anschaffungspreis eines MacBook Air oder Mini.

Aber es läppert sich eben einiges zusammen mit Instrumenten die via USB aka Midi ins System wollen, dem zusätzlichen Audio Interface, Plattenspieler, Kartenleser, externe SSD's, Time Maschine Platte, externer HDD + Backup RAID - da ist ein externer USB Stick der ins System möchte noch gar nicht aufgezählt.

Das ist aber ein generelles Peripherie Problem für das es insbesondere an mobilen Devices ohne entsprechende Docks/Hubs kaum Lösungen gibt.

Aber womöglich bin ich auch eher Special Interest User ;-)

Antwort von Darth Schneider:

@Jott

Es gibt nicht wenige gerade auch Profis, die bevorzugen immer noch kabelgebundene Tastaturen am Rechner.

Auch Mäuse, z.T.

Man sollte die Wahl haben…

Ökologisch ist das auch nicht gerade sinnvoll, überall wo man es gar nicht braucht, unbedingt Batterien einzubauen…;))

Und ich finde/fand viele Apple Produkte wirklich sehr toll.

Aber mit den Anschlüssen so zu knausern wie Apple heute das macht, ist doch schon fast krankhaft idiotisch..

Gruss Boris

Antwort von Jott:

Die knausern doch nicht in den (neueren) MacBooks? Und Mäuse oder Tastaturen mit Kabeln gibt‘s schon ewig (ein Jahrzehnt?) nicht mehr bei Macs. Wer sich daran stört, ist bei Apple wohl falsch.

Wer ein MacBook als Desktop-Ersatz nutzt, hat doch wohl via Thunderbolt einen größeren Monitor dran, und der hat - falls nicht ein grotesker Fehlkauf - den so dringend vermissten Hub für das ganze USB-Geraffel, das man so hat, eingebaut.

Wie oben schon geschrieben: man muss sich schon anstrengen, um ein Haar in der Suppe zu finden.

Antwort von Darth Schneider:

Ja aber das erklärt doch leider auch nicht die nur 2 Anschlüsse an einem Mac Book…

Ein Dongel, und ne ssd anschliessen und schon ist ohne Hub Feierabend, das muss doch nicht sein.

Ist ja nicht so das am oder im Gehäuse kein Platz wäre…

Und gerade wer ein schönes 16 Zoll hat, will doch womöglich gar nicht nen externen Monitor daran.

Gut ich glaube die grossen haben 4 Anschlüsse, aber kein Card Slot, den z.B. ich dauernd brauche.

Und ich froh bin das mein älterer iMac überhaupt noch einen hat…

Gruss Boris

Antwort von markusG:

Jott hat geschrieben:

Wer ein MacBook als Desktop-Ersatz nutzt, hat doch wohl via Thunderbolt einen größeren Monitor dran, und der hat - falls nicht ein grotesker Fehlkauf - den so dringend vermissten Hub für das ganze USB-Geraffel, das man so hat, eingebaut.

Du meinst wie das Studio Display?

Jedenfalls wäre mir ein Thunderbolt Dock tausend Mal lieber als diese proprietären Lösungen anderer Hersteller...

Antwort von Darth Schneider:

Teurer Hub..;)))

Gruss Boris

Antwort von iasi:

Wenn ich bei youtube-Tests höre, dass

bei dem einen Adapter 4k mit mehr als 30p nicht über HDMI ausgegeben wird,

beim anderen die Datenübertragungsraten an USB runter gehen

und und und

dann ist das nicht überzeugend.

Antwort von Jott:

markusG hat geschrieben:

Du meinst wie das Studio Display?

Nö. Seit wann ist Thunderbolt proprietär? Wir haben MacBooks an irgendwelchen günstigen Samsung Wide Screens hängen. Da tummeln sich genug Anschlüsse auf der Rückseite.

Antwort von Jott:

Iasi, wer sich ernsthaft für Macs interessiert, konsultiert besser einen Händler anstelle der YouTube-Academy. Es geht doch um einen Haufen Geld.

Antwort von vaio:

"Darth Schneider" hat geschrieben:

Ja aber das erklärt doch leider auch nicht die nur 2 Anschlüsse an einem Mac Book…

Ein Dongel, und ne ssd anschliessen und schon ist ohne Hub Feierabend, das muss doch nicht sein.

Und hier kommt wieder die „Zielgruppe“ ins Gespräch. Für die meisten Anwender(innen) reichen die 2 USB-Anschlüsse. Für fortgeschrittenen Nutzer gibt es dann die „Pro“ Geräte mit mehr Anschlüsse. Wenn du also ein „fortgeschrittener User“ bist, ist ein mb schlichtweg das falsche Gerät. Oder du arrangierst dich damit, weil du ja weisst, dass das Gerät prinzipiell nicht für dich gemacht ist. Und der Markt ist groß…

Antwort von Darth Schneider:

@vaio

Klar, wahrscheinlich wird es eh ein Mac Studio.

Aber die neuen Mac Minis und auch ein grosses iPad Pro wären für mich auch durchaus möglich, und sehr interessant…;)

Das mit den Zielgruppen stimmt, und irgendwo muss Apple dann ja auch einsparen.

Die MacBooks und Co sind ja wirklich echt günstig…

Gruss Boris

Antwort von markusG:

Jott hat geschrieben:

Nö. Seit wann ist Thunderbolt proprietär?

Hab ich nie behauptet (les meinen Post nochmal falls du es anders verstanden hast).

Der Studio Monitor wurde hier ja mehr oder weniger als einzige valide Lösung für Mac postuliert, u.a. wegen 5k... Was natürlich Quatsch bzw subjektiv ist

Antwort von Jott:

Die Samsungs bei uns sind auch 5K.

Antwort von markusG:

Jott hat geschrieben:

Die Samsungs bei uns sind auch 5K.

Du weißt ganz genau dass es um die DPI geht, und da kannst du Widescreens nicht 1:1 vergleichen...

Aber wie gesagt: ist auch bissel subjektiv. Persönlich würde ich nicht mehr zu non-widescreen zurück. Und alles besser als die proprietären Lösungen a la Dell oder Microsoft...

Antwort von Jott:

Die 5k quer sind perfekt für eine Mega-Timeline, auch unter ergonomisch/optischen Gesichtspunkten. Es gibt die gleichen Monitore auch mit niedrigerer Auflösung,

das geht dann gar nicht. Gruselig. Den meisten reicht‘s aber trotzdem. Der Markt bietet alles für jeden, keine Ahnung, wo das Problem ist.

Vielleicht gibt‘s ja non-Apple-Laptops mit sechs oder acht USB-Anschlüssen, dann nimmt man halt so was. Um fcp kann‘s ja nicht gehen, so was fasst ja keiner an, der was auf sich hält! :-)

Was ich Apple gar nicht verzeihen kann, ist die Versenkung des 27“ iMacs. Diese immer preiswerte Kombi aus flottem Rechner mit fast geschenktem Top-Bildschirm. Wie geil wäre der mit M2-Innenleben. Soll wohl nicht mehr sein.

Antwort von Axel:

Jott hat geschrieben:

Was ich Apple gar nicht verzeihen kann, ist die Versenkung des 27“ iMacs. Diese immer preiswerte Kombi aus flottem Rechner mit fast geschenktem Top-Bildschirm. Wie geil wäre der mit M2-Innenleben. Soll wohl nicht mehr sein.

Ein Apple Studio Display mit 1749€ plus ein M2 Mini mit der empfehlenswerten Ausstattung 16GB U-RAM und 512GB Speicher kostet 1159€. Zusammen 2908€. Mit einer vergleichbaren Leistung gab‘s noch keinen iMac, inklusive eines vollausgebauten iMac Pros. Ich habe schon ein eigentlich tadelloses 5k Display (mit halt auf Intel laufendem, aber sozusagen tadellosem Computer drin) verschenkt. Luke Miani hat mehrere DIY-Tutorials, wie man einen 5k iMac in ein Studiodisplay ummodelt. Außerdem stellte Marques Brownlee mal eine günstigere Alternative zum Studio-Display (Samsung? LG?) vor, die allerdings bei näherer Betrachtung nicht mehr sooo viel günstiger war und bei noch näherer Betrachtung weder so funktionell noch so schön.

Antwort von Jott:

Da ist was dran, der neue MacMini ist tatsächlich recht günstig.

Antwort von Darth Schneider:

Der neue M2 Mac Mini ist ein Schnäppchen.

Der alte Mac Mini aber auch immer noch.;))

Theoretisch kann man sich auch das 700€ M2 Basis Model kaufen, und einfach auf einer externen Ssd bequem schneiden.

(Geht übrigens auch schon mit meinem neuen M1 iPad Air, zusammen mit Resolve.)

Gruss Boris

Antwort von Axel:

"Darth Schneider" hat geschrieben:

Theoretisch kann man sich auch das 700€ M2 Basis Model kaufen, und einfach auf einer externen Ssd bequem schneiden.

8GB werden schnell erreicht mit FCP und zumal mit Resolve. Zuerst merkt man das kaum, weil RAM-Inhalte kurzzeitig auf die SSD geschrieben werden, genannt swap. Aber 8GB-Besitzer (bei M1) berichten von Beachballs. Außerdem verkürzt das Swapping die Lebensdauer der SSD, die extrem häufig überschrieben wird. Eine 512GB SSD hat statistisch gesehen die doppelte Lebensdauer einer 256er, ohne allzu viel Swapping über 5 Jahre, eine 1TB über 10. Natürlich benötigt in 10 Jahren die KI, die die Filme aus deinen Tagträumen generiert, eh eine ganz andere Architektur, weswegen 512 plus Apple Care die klügere Investition wäre.

Antwort von andieymi:

Axel hat geschrieben:

"Darth Schneider" hat geschrieben:

Theoretisch kann man sich auch das 700€ M2 Basis Model kaufen, und einfach auf einer externen Ssd bequem schneiden.

8GB werden schnell erreicht mit FCP und zumal mit Resolve. Zuerst merkt man das kaum, weil RAM-Inhalte kurzzeitig auf die SSD geschrieben werden, genannt swap. Aber 8GB-Besitzer (bei M1) berichten von Beachballs. Außerdem verkürzt das Swapping die Lebensdauer der SSD, die extrem häufig überschrieben wird. Eine 512GB SSD hat statistisch gesehen die doppelte Lebensdauer einer 256er, ohne allzu viel Swapping über 5 Jahre, eine 1TB über 10. Natürlich benötigt in 10 Jahren die KI, die die Filme aus deinen Tagträumen generiert, eh eine ganz andere Architektur, weswegen 512 plus Apple Care die klügere Investition wäre.

Das ist ein valides Argument, und trotzdem liegt gerade da der Vorteil von SoC ggü. herkömmlicher Mainboard-Konfiguration. Dass das viel nahtloser & schneller geht, als damals als Idee für HDD-SSD Swaps bei den Ultrabooks, spricht auch nicht gegen die Konfiguration.

Wenn die M1-Macs mit 8GB sterben würden wie die Fliegen hätten wir das nach 2 Jahren schon gehört. Und soweit ich weiß, gabs da nur besorgte Nutzer, die sich darüber prophylaktisch Gedanken gemacht haben, keinen großen Schwund. Wenn man glaubt, dass ein Laptop heute noch 6-8 Jahr hält, naja. Dann mag das ein Argument sein. Aber das ist auch der Zeitraum, wo jede SSD ohne Swap irgendwann an die Grenzen kommen wird.

Antwort von Axel:

andieymi hat geschrieben:

Wenn die M1-Macs mit 8GB sterben würden wie die Fliegen hätten wir das nach 2 Jahren schon gehört.

Lassen wir die Lebensdauer mal außen vor. Es gibt zahlreiche Reviews, vor allem mit Resolve, die zeigen, dass 16GB einen spürbaren Unterschied machen. 32GB (MBP, Studio) sind auch besser, aber nicht mehr Welt bewegend, für FCP kaum relevant.

512 nahm ich damals, weil mit via Mainstage reingeholten Logic-Loops und VSTs 256 ein bisschen eng wurden. Ansonsten stimmt‘s, man braucht keine 512.

Antwort von vaio:

andieymi hat geschrieben:

Wenn man glaubt, dass ein Laptop heute noch 6-8 Jahr hält, naja. Dann mag das ein Argument sein. Aber das ist auch der Zeitraum, wo jede SSD ohne Swap irgendwann an die Grenzen kommen wird.

Die 512 GB SSD in meinem fast 10 Jahre alten 15“ mbp (late 2013 mit 16 GB RAM) funzt nach wie vor tadellos. Dauerhaft war/ist sie überwiegend zu 50 % belegt. In seltenen Fällen temporär zu 90% gefüllt gewesen. Ich denke, dass die noch weitere 10 Jahre halten würde…

Den bestellten mac mini pro hab ich von der Grundkonfiguration gelassen, bis auf die SSD (1 TB). Abgesehen von dem „Mehr an Kapazität“, sind die optionalen SSD‘s oftmals auch ein wenig flinker, als der Basisspeicher (bzw. der Basisspeicher ist zeitgemäß relativ langsam).

Antwort von XyZ-3D:

RAM:

Hatte damals den allerersten Mini sofort gekauft mit 16GB, seit ein paar Monaten Studio mit 64GB. Was keinesfalls zuviel ist, im Gegenteil. Sehe hier einen Schwachpunkt des neuen Mini.

Anschlüsse:

Der erste Mini war in diesem Punkt tendenziell viel zu mager bestückt, v.a. wenn man bedenkt, dass das Gehäuse quasi leer war (Platine wie im iPhone).

Der Studio übertrifft quasi jede Workstation, nicht nur weil dieser 12 brauchbare Buchsen direkt am Gerät selber hat, sondern wegen TB (und natürlich USB für das Fußvolk). Da gibt es wirklich nichts mehr zu jammern.

Antwort von MarcusG:

Hier erste Benchmarks was die Grafikleistung mit 38 Kernen im Vergleich zu Nvidia angeht:

https://www.notebookcheck.com/Apple-M2- ... 154.0.html

Es gibt auch inzwischen sehr krasse Videos von der Nvidia 4080 wie sehr diese AI Funktionen wie Magic Mask, Depth Map und Noise reduction beschleunigt. Wer das oft braucht sollte wohl eher die Windows Schiene fahren. Wobei natürlich Apple auch oft eine bessere Leistung bringt als die reinen Zahlen vermuten lassen. Vielleicht muss man da noch Praxistests mit Fusion und den AI Funktionen abwarten.

Antwort von Rick SSon:

MarcusG hat geschrieben:

Hier eine Demo einer RTX 3090 (35Tflops) vs M1:

Hier eine Tabelle der TFlops Versch. Grafikkarten:

https://www.pc-erfahrung.de/grafikkarte ... liste.html

Der Grafikchip des M2 Max im Vollausbau mit 38 cores wird 13Tflops erreichen, das ist auf dem Niveau einer 2080, was sich gut anhört, aber halt weit hinter aktuellen Grafikkarten liegt und im Preis Richtung 7000€ gehen wird. Für den Preis kann ich Resolve mit 2 Nvidia Grafikkarten nutzen

Der Vergleich hinkt halt leider - wie immer.

Habe hier ein M1 Max (32 GB) und einen PC mit 7950x, 128GB und 4090 im direkten Vergleich.

Im Gesamterlebnis gewinnt der M1 hier immernoch (Stabilität, Flexibilität). In den meisten Schnittprojekten merkt man in der Geschwindigkeit keinen Unterschied, der PC hängt sich aber deutlich häufiger auf (sowohl unreal engine unter win als auch resolve unter linux)

Antwort von Jott:

Wer kauft sich denn einen Mac zum Spielen? Das ist doch eine völlig exotische Betrachtung.

Wie wär's mit Warten bis zum Verkaufsstart, dann kommen sicher schnell die üblichen Verdächtigen mit irgendwelchen Stoppuhr-Checks rüber, für Tasks im Videobereich (Adobe, Blackmagic, fcp, Motion ...).

Antwort von Axel:

Ming-Chi Kuo berichtet inzwischen, dass TSMC gerade den letzten Schliff an M3-Chips legt, mit 3-Nanometer-Architektur. Und dass vor dem 2024 WWDC Apple auch M3 Macs vorstellen werde. Die Leistungssteigerung, die damit möglich wäre …

Antwort von Frank Glencairn:

"Rick SSon" hat geschrieben:

Der Vergleich hinkt halt leider - wie immer.

Habe hier ein M1 Max (32 GB) und einen PC mit 7950x, 128GB und 4090 im direkten Vergleich.

Ja und nein - kommt halt auf die Metrik an.

Wenn der Mac das Selbe kostet wie der PC, verliert der Mac.

Wenn der PC das Doppelte kostet, verliert der PC.

Wenn ich ein Programm vergleiche, das auf dem einen Rechner Hardwareunterstützung hat, auf dem anderen aber nicht - dann hinkt der Vergleich allerdings.

"Rick SSon" hat geschrieben:

Im Gesamterlebnis gewinnt der M1 hier immernoch (Stabilität, Flexibilität). In den meisten Schnittprojekten merkt man in der Geschwindigkeit keinen Unterschied, der PC hängt sich aber deutlich häufiger auf (sowohl unreal engine unter win als auch resolve unter linux)

Wenn dein PC instabil ist, machst du was falsch - und von welcher angeblichen "Flexibilität" reden wir hier eigentlich?

Antwort von rush:

"Rick SSon" hat geschrieben:

der PC hängt sich aber deutlich häufiger auf (sowohl unreal engine unter win als auch resolve unter linux)

Was dann aber doch möglicherweise ein völlig anders geartetes Problem sein kann und sicherlich nicht zu verallgemeinern ist.

Ein solide zusammengestelltes PC System sollte im Idealfall auch rock solid und ohne Abstürze laufen - da liegt das Problem meist woanders begraben (Netzteile, Thermik, Ram-Fehlkonfigurationen bzw. generell schlechte Konfiguration...) .

Die Effizienz und Leistungsfähigkeiten der modernen Mac's ist aber in der Tat wirklich hervorragend - da sehen PC Systeme aktuell kein Land.

Die künftige M3 Generation (sofern da wirklich schon auf 3nm umgestellt werden sollte) könnte in der Tat eine spannende Perspektive nach dem M1 Air in einigen Jahren werden.

Antwort von DKPost:

Ist der maxed out Studio Mac momentan der leistungsstärkste Mac, oder gibt es da noch etwas anderes?

Antwort von andieymi:

Ich schätze, dass in einzelnen speziellen Szenarien ein gut ausgebauter Mac Pro (den es immer noch gibt, bis zu 28-Xenon-Kernen (Intel), bis zu 1,5TB-ECC-RAM, bis zu 128GB GPU-Speicher) noch die Nase vorn hat. Aber zu einem absolut exorbitanten Preis.

Der M1 Ultra dürfte tatsächlich mittlerweile (Software muss mitziehen) nach vielen Benchmarks die ich kenne in vielen Bereichen deutlich schneller sein und ist maxed out (abgesehen von SSD) preislich dort, wo der Mac Pro anfängt, bei ca. 7000€. Für Maximierung des Mac Pro werden dann um die 50.000€ fällig.

Das zeigt schon, was tendenziell in der Plattform steckt. Klar kann nicht jeder Base-Spec-M1 alles, aber wenn man am oberen Ende schaut, dann dürten die Szenarien, wo ein 15000-2000€ (von 50 rede ich gar nicht) Mac Pro notwendig ist und was ein Studio M1 Ultra um 7000€ nicht schafft, deutlich weniger geworden sein. Der bringt ja auch wieder seine 20-CPU-Kerne, 64-CPU-Kerne und 128GB RAM mit (also deutlich mehr als die Basis 8GB).

Aber: Cuda könnte so ein Szenario sein. Und da kann dann bald mal auch der 3000-4000€ Windows/Nvidia-Selbstbaurechner wieder mitspielen, selbst vgl. mit dem M1 Ultra.

Antwort von Rick SSon:

"Frank Glencairn" hat geschrieben:

"Rick SSon" hat geschrieben:

Der Vergleich hinkt halt leider - wie immer.

Habe hier ein M1 Max (32 GB) und einen PC mit 7950x, 128GB und 4090 im direkten Vergleich.

Ja und nein - kommt halt auf die Metrik an.

Wenn der Mac das Selbe kostet wie der PC, verliert der Mac.

Wenn der PC das Doppelte kostet, verliert der PC.

Wenn ich ein Programm vergleiche, das auf dem einen Rechner Hardwareunterstützung hat, auf dem anderen aber nicht - dann hinkt der Vergleich allerdings.

"Rick SSon" hat geschrieben:

Im Gesamterlebnis gewinnt der M1 hier immernoch (Stabilität, Flexibilität). In den meisten Schnittprojekten merkt man in der Geschwindigkeit keinen Unterschied, der PC hängt sich aber deutlich häufiger auf (sowohl unreal engine unter win als auch resolve unter linux)

Wenn dein PC instabil ist, machst du was falsch - und von welcher angeblichen "Flexibilität" reden wir hier eigentlich?

Mein PC ist nicht instabil, die M1 optimierte Software läuft einfach stabiler, als die Windowsvariante. Klar, das kann auch daran liegen, dass ich irgendeine andere der drölftausend Grafiktreiberversionen installieren muss, oder dass die neue AMD Plattform noch nicht so ausgereift ist (wieso eigentlich?). Als PC-User findet man das eben normal, dass man in Troubleshooting Zeit investiert, aber in der Firmenrealität ist das auch Arbeitszeit und die wird dem Gerätepreis angerechnet.

Auch meine Mitarbeiter freuen sich über die Macs und ich höre weniger oft, dass irgendwas nicht geht.

Da gewinnt nach meiner Erfahrung (leider) der PC bei weitem nicht mehr. Mac kaufe ich, schalte ich an, logge meine Apple-ID ein, gehe Mittagessen und arbeite danach direkt weiter, als wäre es noch das „alte“ Gerät.

Weisst du doch aber alles selber, wieso muss ich das überhaupt nochmal erklären? 😄

Früher, zu WG-Zeiten, als ich als Freelancer angefangen habe, da hab ich auch an PCs rumgefrickelt. Hat auch Spass gemacht, ich hatte mehr Zeit, die Zeit war nicht so teuer. Alles cool. Heute kriege ich von meinen Geschäftspartnern auf den Sack, wenn zuviel rumgebastelt wird 😂

Antwort von Frank Glencairn:

"Rick SSon" hat geschrieben:

,,,die M1 optimierte Software läuft einfach stabiler, als die Windowsvariante.

Ich glaub Resolve ist mir in all den Jahren vielleicht 3-4 mal abgestürzt, und meistens war es irgend ein Plugin, das Ärger gemacht hat.

Antwort von Rick SSon:

"Frank Glencairn" hat geschrieben:

"Rick SSon" hat geschrieben:

,,,die M1 optimierte Software läuft einfach stabiler, als die Windowsvariante.

Ich glaub Resolve ist mir in all den Jahren vielleicht 3-4 mal abgestürzt, und meistens war es irgend ein Plugin, das Ärger gemacht hat.

Weiss nicht was du da alles machst, wir machen einige Projekte mit Animationsanteil in Fusion, da knabbert die Ressourcenverwaltung von Windows ganz schön. Sobald Fusion im Spiel ist macht man gefühlt ne ganz andere Kiste auf, als nur bisl Schnitt und Grading. Wegen 30 Nodes im Color Tab schwitzt aber heutzutage auch sogut wie kein System mehr.

Antwort von Darth Schneider:

Also das mit Fusion empfinde ich auch so, gut das liegt aber am in meinem Fall eh am RAM…

Gruss Boris

Antwort von markusG:

Axel hat geschrieben:

Ein Apple Studio Display mit 1749€ plus ein M2 Mini mit der empfehlenswerten Ausstattung 16GB U-RAM und 512GB Speicher kostet 1159€. Zusammen 2908€. Mit einer vergleichbaren Leistung gab‘s noch keinen iMac, inklusive eines vollausgebauten iMac Pros.

Es geht aber auch um das "dazwischen", sprich: einen "Basic" iMac, mit großem Display.

Einen 24er iMac kriegst du für knapp 1200€, den LG ultrafine 5k für knapp 1000€. Sollte im Endeffekt für einen iMac zum Preis der Intel Variante reichen und immer noch flott genug sein für den Großteil der Anwendungen, und eben zukunftssicher.

Damit würde auch Apple halt in der Situation befinden, dass das Studio Display als überteuert da stünde. Nützt "uns" halt nur nichts :(

Antwort von MarcusG:

Hier ein Vergleich im VFX Bereich, High End Workstation vs M2 Max 96GB

Antwort von freezer:

"Frank Glencairn" hat geschrieben:

"Rick SSon" hat geschrieben:

,,,die M1 optimierte Software läuft einfach stabiler, als die Windowsvariante.

Ich glaub Resolve ist mir in all den Jahren vielleicht 3-4 mal abgestürzt, und meistens war es irgend ein Plugin, das Ärger gemacht hat.

Ich konnte es heute beim Schnitt zuverlässig zum Absturz bringen indem ich die Nurton-Spur von einem Video mehrfach duplizierte und mit Crossfades versah (eine Atmoschleife sozusagen). Wenn ich dann die 4 Clips auswählte und per ALT eine Kopie verschieben wollte und dabei kurz über eine andere Spur mit Audio fuhr, dann hat es Resolve zuverlässig jedesmal ausgehoben.

Antwort von iasi:

MarcusG hat geschrieben:

Hier ein Vergleich im VFX Bereich, High End Workstation vs M2 Max 96GB

Nun ja - nicht schlecht, aber nun doch auch nicht der Überflieger, als der das Ding gehypte wird.

Das eher lahme Windows-Notebook wird auch ncht gerade mit wehenden Fahnen übertrumpft.

Ernüchternd.

Antwort von Frank Glencairn:

9-5 Stunden?

Was für ein Programm nutzen die denn in aller Welt um ein DCP zu rechnen?

Normal geht das in Echtzeit oder schneller.

Antwort von Darth Schneider:

Ein sehr langer Spielfilm…;)))

Gruss Boris

Antwort von iasi:

"Frank Glencairn" hat geschrieben:

9-5 Stunden?

Was für ein Programm nutzen die denn in aller Welt um ein DCP zu rechnen?

Normal geht das in Echtzeit oder schneller.

Das hängt davon ab.

Premiere liefert z.B. - sagen wir mal - exaktere Ergebnisse beim Export ohne GPU-Nutzung und reiner CPU-Berechnung - jedenfalls unter Windows.

After Effekts neigt auch nicht unbedingt zu Echtzeit.

Es kommt wohl auch auf das Programm an, das genutzt wurde.

Zudem kommt es auch sehr darauf an, wie komplex das Projekt war.

Antwort von DKPost:

iasi hat geschrieben:

"Frank Glencairn" hat geschrieben:

9-5 Stunden?

Was für ein Programm nutzen die denn in aller Welt um ein DCP zu rechnen?

Normal geht das in Echtzeit oder schneller.

Das hängt davon ab.

Premiere liefert z.B. - sagen wir mal - exaktere Ergebnisse beim Export ohne GPU-Nutzung und reiner CPU-Berechnung - jedenfalls unter Windows.

After Effekts neigt auch nicht unbedingt zu Echtzeit.

Es kommt wohl auch auf das Programm an, das genutzt wurde.

Zudem kommt es auch sehr darauf an, wie komplex das Projekt war.

Inwiefern sind die Ergebkisse ohne GPU denn exakter, bzw. was soll exakter in dem Kontext bedeuten?

Antwort von MarcusG:

iasi hat geschrieben:

MarcusG hat geschrieben:

Hier ein Vergleich im VFX Bereich, High End Workstation vs M2 Max 96GB

Nun ja - nicht schlecht, aber nun doch auch nicht der Überflieger, als der das Ding gehypte wird.

Das eher lahme Windows-Notebook wird auch ncht gerade mit wehenden Fahnen übertrumpft.

Ernüchternd.

Es kommt halt darauf an was einem wichtig ist. Wenn man es an den Renderzeiten misst war das einfach zu erwarten. Aber dass was gesagt wird über Energieeffizienz, Mobilität und dass es eben einfach schnell große Szenen lädt, den 96GB VRAM mit der Grafikkarte teilt und in der Bedienung flutscht, und auch unter Last nicht laut wird wie ein Laubbläser, was ich alles sehr wichtig finde, dann ist es ein Notebook dass es vorher einfach so nicht ansatzweise zu kaufen gab. Man muss sich halt überlegen wie viel Geld das einem Wert ist und wie es das Video gut vorlebt ist es eben kein Ersatz für eine Windows Workstation sondern eine gute Ergänzung.

Antwort von iasi:

MarcusG hat geschrieben:

iasi hat geschrieben:

Nun ja - nicht schlecht, aber nun doch auch nicht der Überflieger, als der das Ding gehypte wird.

Das eher lahme Windows-Notebook wird auch ncht gerade mit wehenden Fahnen übertrumpft.

Ernüchternd.

Es kommt halt darauf an was einem wichtig ist. Wenn man es an den Renderzeiten misst war das einfach zu erwarten. Aber dass was gesagt wird über Energieeffizienz, Mobilität und dass es eben einfach schnell große Szenen lädt, den 96GB VRAM mit der Grafikkarte teilt und in der Bedienung flutscht, und auch unter Last nicht laut wird wie ein Laubbläser, was ich alles sehr wichtig finde, dann ist es ein Notebook dass es vorher einfach so nicht ansatzweise zu kaufen gab. Man muss sich halt überlegen wie viel Geld das einem Wert ist und wie es das Video gut vorlebt ist es eben kein Ersatz für eine Windows Workstation sondern eine gute Ergänzung.

Die M2 sind sehr leistungsfähig und effizient - keine Frage.

Nur klang es immer so, als wären sie die Überflieger.

Windows-Notebooks der ähnlichen Preisklasse sind jedoch offensichtlich ebenso leistungsfähig und bieten weit mehr Variantenauswahl.

So ein Titel ist schließlich nicht ohne:

MacBook Pro 16" mit M2 Max Chip, 96 GB RAM und 8 TB SSD kostet mehr als 8300 Dollar

https://gagadget.com/de/208991-macbook- ... 00-dollar/

Antwort von Jott:

Immer die gleiche Leier: Vollausbau gucken und Kreisch! :-)

Antwort von DKPost:

Ist ein Mac Studio mit M2 eigentlich bestätigt, oder ist das bisher nur Spekulation? Auf den wäre ich echt gespannt.

Antwort von iasi:

Jott hat geschrieben:

Immer die gleiche Leier: Vollausbau gucken und Kreisch! :-)

Immer die gleiche Leier: Vollausbau-Test gucken und Huuui! :-)

Antwort von Frank Glencairn:

iasi hat geschrieben:

"Frank Glencairn" hat geschrieben:

9-5 Stunden?

Was für ein Programm nutzen die denn in aller Welt um ein DCP zu rechnen?

Normal geht das in Echtzeit oder schneller.

Das hängt davon ab.

Premiere liefert z.B. - sagen wir mal - exaktere Ergebnisse beim Export ohne GPU-Nutzung und reiner CPU-Berechnung - jedenfalls unter Windows.

After Effekts neigt auch nicht unbedingt zu Echtzeit.

Es kommt wohl auch auf das Programm an, das genutzt wurde.

Zudem kommt es auch sehr darauf an, wie komplex das Projekt war.

Und was hat das jetzt mit DCPs zu tun?

Die rechnet man für gewöhnlich von einem Master file.

Antwort von Jott:

Wie immer: ist Apple zu teuer, dann Finger weg und was anderes nehmen - oder besser gleich gar nichts. Denn wer würde etwas kaufen, was er gar nicht braucht? Kindergarten.

Und Autoren wie der oben zitierte, die jammern, dass Rechner hier teurer sind als in den USA, haben noch nie was von Mehrwertsteuer/VAT gehört. Die in den USA noch nicht im genannten Preis enthalten ist, hier aber schon. Muss man vielleicht auch mal wieder hinschreiben in der aktuellen Empörungsphase! :-)

Antwort von Jott:

DKPost hat geschrieben:

Ist ein Mac Studio mit M2 eigentlich bestätigt, oder ist das bisher nur Spekulation? Auf den wäre ich echt gespannt.

Bei Apple ist alles Spekulation, was nicht offiziell vorgestellt wurde. Man spekuliert auch, dass noch dieses Jahr M3 kommt.

Ganz einfach: wer immer warten kann, braucht keinen neuen Rechner. Die Erkenntnis spart einen Haufen Geld.

Antwort von Darth Schneider:

Dieses Jahr ?

Die spinnen doch aber auch langsam…;)))

Gruss Boris

Antwort von rush:

Jott hat geschrieben:

Die in den USA noch nicht im genannten Preis enthalten ist, hier aber schon. Muss man vielleicht auch mal wieder hinschreiben in der aktuellen Empörungsphase! :-)

Auch die Nettopreise sind in den Staaten seit Jahren etwa 10-15% geringer als hierzulande - auch das gehört bei Apple zur Wahrheit.

Man behält sich Kursschwankungen vor und lässt entsprechend einen Puffer - wohl wissend das der Euro nicht unbedingt an Stärke gewinnt... Aus unternehmerischer Sicht nachvollziehbar - für Endkunden weniger glücklich.

Ist aber in der Tat nichts Neues...

Antwort von Jott:

Zur Wahrheit führt nicht der unerschütterliche Glaube an das Böse im Obst, sondern der Taschenrechner. Aber egal. Wer meint, besser in den USA zu kaufen, kann das ja tun.

Antwort von markusG:

Jott hat geschrieben:

DKPost hat geschrieben:

Ist ein Mac Studio mit M2 eigentlich bestätigt, oder ist das bisher nur Spekulation? Auf den wäre ich echt gespannt.

Bei Apple ist alles Spekulation, was nicht offiziell vorgestellt wurde. Man spekuliert auch, dass noch dieses Jahr M3 kommt.

Ja, der gemutmaßte M2 Extreme (u.a. auch um sich vom kommenden Studio-Refresh abzugrenzen) wurde ja gestrichen. RAM lässt sich angeblich im kommenden Pro auch nicht aufrüsten, so dass die Nutzerschaft imho auf diejenigen zusammenschrumpft, die auf Erweiterungskarten* angewiesen sind...naja mal schauen was da Apple aus dem Hut zaubern wird :)

*wenn Apple dann endlich dedizierte GPUs unterstützen sollte, ist auch dieses Argument mal so langsam vom Tisch.

Antwort von DKPost:

markusG hat geschrieben:

Jott hat geschrieben:

Bei Apple ist alles Spekulation, was nicht offiziell vorgestellt wurde. Man spekuliert auch, dass noch dieses Jahr M3 kommt.

Ja, der gemutmaßte M2 Extreme (u.a. auch um sich vom kommenden Studio-Refresh abzugrenzen) wurde ja gestrichen. RAM lässt sich angeblich im kommenden Pro auch nicht aufrüsten, so dass die Nutzerschaft imho auf diejenigen zusammenschrumpft, die auf Erweiterungskarten* angewiesen sind...naja mal schauen was da Apple aus dem Hut zaubern wird :)

*wenn Apple dann endlich dedizierte GPUs unterstützen sollte, ist auch dieses Argument mal so langsam vom Tisch.

Das mit den dedizierten GPUs hat sich mit den M-Chips doch erledigt, oder? Und scheinbar ist das ja auch gut so wenn man sich die Leistung so anschaut.

Ich hatte es damals schon beim Release der M1-Chips geschrieben: Es wird spannend inwieweit Apple die Chips und die Leistung skalieren kann. Momentan reicht es noch nicht ganz, aber die Richtung stimmt.

Antwort von markusG:

DKPost hat geschrieben:

Das mit den dedizierten GPUs hat sich mit den M-Chips doch erledigt, oder? Und scheinbar ist das ja auch gut so wenn man sich die Leistung so anschaut.

Keine Ahnung ob da noch was von Apple kommt. Aber die GPU ist ja eben noch nicht da wo es sein könnte - alles was nicht optimiert ist und auf rohe Leistung angewiesen ist (denoise, 3D...) strauchelt

noch im Vergleich. Das mag für viele ein Grenzfall sein, daher sehe ich es wenn Apple es irgendwo ermöglicht, dann im Pro (wo sonst macht es sonst Sinn).

Antwort von iasi:

Jott hat geschrieben:

Wie immer: ist Apple zu teuer, dann Finger weg und was anderes nehmen - oder besser gleich gar nichts. Denn wer würde etwas kaufen, was er gar nicht braucht? Kindergarten.

Und Autoren wie der oben zitierte, die jammern, dass Rechner hier teurer sind als in den USA, haben noch nie was von Mehrwertsteuer/VAT gehört. Die in den USA noch nicht im genannten Preis enthalten ist, hier aber schon. Muss man vielleicht auch mal wieder hinschreiben in der aktuellen Empörungsphase! :-)

Richtig.

Das Gute bei echten Profis ist ja immer, dass sie nicht aufs Geld schauen müssen.

Wenn"s beruflich genutzt wird, ist es völlig egal was es kostet. Man schreibt"s ja eh von der Steuer ab. :) ;)

Zuletzt hatte ich das von einem Profi gehört, der sich kurze Zeit später über seine Banken aufgeregen musste, weil sie ihm keine weiteren Kredite mehr genehmigen wollten und er Insolvenz anmelden musste - die bösen Banken.

Antwort von Darth Schneider:

In den USA kaufen um den Mac dann über die Grenze zu schmuggeln würde ich gleich sein lassen und lieber gleich hier kaufen mehr bezahlen als dann die Busse.;)))

Weil mit der Seriennummer können die am Zoll dann ganz einfach herausfinden wo das Gerät gekauft wurde….

Und nicht nur Apple ist teuer, es gibt doch durchaus auch teure PCs…

Gruss Boris

Antwort von iasi:

"Frank Glencairn" hat geschrieben:

iasi hat geschrieben:

Das hängt davon ab.

Premiere liefert z.B. - sagen wir mal - exaktere Ergebnisse beim Export ohne GPU-Nutzung und reiner CPU-Berechnung - jedenfalls unter Windows.

After Effekts neigt auch nicht unbedingt zu Echtzeit.

Es kommt wohl auch auf das Programm an, das genutzt wurde.

Zudem kommt es auch sehr darauf an, wie komplex das Projekt war.

Und was hat das jetzt mit DCPs zu tun?

Die rechnet man für gewöhnlich von einem Master file.

DCPs erfordern das richtige Video- und Audio-Format, was man direkt aus dem Projekt exportiert.

Ein Master-file dazwischen einzuschieben hat seine Vor- und Nachteile.

Zwingend ist es jedenfalls nicht und rausrechnen musst du es auch erstmal.

Antwort von iasi:

"Darth Schneider" hat geschrieben:

Und nicht nur Apple ist teuer, es gibt doch durchaus auch teure PCs…

Gruss Boris

Bei Apple denke ich immer an die Kapitalrendite, die bei satten 25% liegt. :)

Die Frage ist doch, welche Leistung bekommt man für"s Geld.

Windows-Notebooks in der gleichen Preisklasse sind durchaus leistungsfähiger in manchen Bereichen.

Wie liegt dem M2 denn z.B. Raw-Material?

Wie leicht oder schwer tut sich ein M2 beim Export z.B. in - wie Frank sagt - ein Master-file?

Antwort von Darth Schneider:

@iasi