Frage von freezer:Kam grad per Email-Newsletter:

Video Enhance AI v2.0 is here!

Major UI overhaul.

We've refreshed our user interface to provide for a better user experience.

Artemis AI model updates .

Artemis LQ and MQ v11 evolve from Artemis v10 with added ability to handle over-sharpening artifacts in medium or low-quality progressive input videos.

Improved deinterlacing models.

Dione TV and TD v2 are enhanced from v1 to remove over-sharpening artifacts in medium or low quality interlaced input videos.

Und es gibt gerade wiedermal eine Preisaktion: statt um $299 derzeit um $149,99

Bin schwach geworden und habs mir zugelegt, schon weil ich neugierig bin auf die Ergebnisse der Verbesserungen.

Beim Auschecken kam die Option einen Promo Code einzugeben und kurzes Googlen brachte mir diesen -15% Promo Code der tatsächlich funktioniert:

Doorhof99

Damit kostet die Software $127,49 was beim derzeitigen Dollarkurs rund 100 Euro sind.

Vielleicht für den einen oder anderen ebenfalls interessant.

EDIT:

Was auf der Topaz Labs Webseite leider ziemlich untergeht: Das Tool läuft nicht mehr unter Windows 7, da auf DirectX 12 aufsetzend. Die Installation lief bei mir an der Win 7 Workstation brav durch und liefert beim Starten dann erst den Fehler, dass es die DirectX 12 DLL nicht finden kann. Schwache Meldung...

Muss ich damit wohl am Laptop arbeiten...

Antwort von Frank Glencairn:

Verdammt - bisher hab ich nocht nicht mal die letzte Version für irgendwas außer Tests

einsetzen können, und jetzt kommen die mit ner neuen. Es hört nie auf :D

Antwort von freezer:

"Frank Glencairn" hat geschrieben:

Verdammt - bisher hab ich nocht nicht mal die letzte Version für irgendwas außer Tests

einsetzen können, und jetzt kommen die mit ner neuen. Es hört nie auf :D

Ich weiß was Du meinst. Hatte mal eine ältere Demo geladen aber kam nie zum Testen.

Und jetzt lerne ich auch noch Blender und bin erschlagen von dem ganzen Zeug. Immerhin konnte ich nach einem Arbeitstag ein Modell laden, sich drehen lassen und mit Alphakanal rausrendern. Hat mich nur 8 Stunden gekostet :D

Aber immer noch besser als 1994 mit dem Amiga 1200 (68030 @ 50 MHz) und Lightwave3D 3.0 eine Woche an einer 20 Sekunden Animation in SD 50i zu rendern, die Frames auf 20 Disketten zu kopieren und dann in einem Amiga-Laden in den DigitalBroadcaster zu kopieren um die Animation in Echtzeit anschauen zu können.

Antwort von acrossthewire:

Und nach einem Jahr gibt es keine Updates mehr.

Antwort von freezer:

acrossthewire hat geschrieben:

Und nach einem Jahr gibt es keine Updates mehr.

Du kannst ja Updates dazukaufen. 1 Jahr Verlängerung kostet $99 und der 15% Discount geht auch da.

Antwort von slashCAM:

Topaz Labs hat die Version 2.0.0 seines Video Enhance AI veröffentlicht, welche einige Neuerungen und Verbesserungen mitbringt - zudem gibt es während einer zeitlich be...

Hier geht es zur Newsmeldung auf den slashCAM Magazin-Seiten:

Topaz Labs Video Enhance AI 2.0: Videoverbesserungen per KI zum Sonderpreis

Antwort von Bruno Peter:

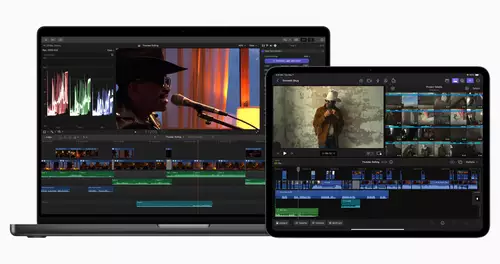

Sind diese AI-Tools in irgendeinem NLE - EDIUS, DaVinci - als Plug-in nutzbar oder nur als Solo-Programm?

Antwort von MK:

Video Enhance AI Nur solo... würde als Plugin auch keinen Sinn machen da die Hardwareanforderungen zu hoch sind.

Die anderen Tools für Einzelbilder (Gigapixel, etc.) binden sich teilweise in z.B. Photoshop ein.

Antwort von rush:

Und wie sind Eure Erfahrungen mit dieser AI-Software? Bringt das was? Halbwegs sinnvoll zu gebrauchen in Hinblick auf's Denoising? Upscaling?

Oder eher viel Marketing und begrenzter Nutzen?

Antwort von roki100:

also wenn ich mir manche Videos davon anschaue, dann sieht es eher nach Midtone Detail + Sharpness mischung aus....wenn man das manuell z.B. in DR macht, kommen Noises zum Vorschein...deswegen ist denoiser auch mit dabei? Wahrscheinlich funktioniert der denoiser ähnlich wie NeatVideo?

Antwort von Jott:

Wenn das De-Interlacing plus Upscaling so gut aussieht wie in den Demos, dann lohnt sich das.

Antwort von medienonkel:

Also bei mir lief die Demo der ersten Version noch ein halbes Jahr lang... Hatte da einen relativ alten Clip aus S-VHS Zeiten durchgejagt: ich war komplett positiv schockiert, was die Software an manchen Stellen an Hautdetail "korrekt" dazu gerechnet hat. Mittlerweile gibt es viel mehr trainierte und spezialisierte Netzwerke. Eigentlich fehlt nur noch eine KI, die das Material vorher checkt und die optimalen Einstellungen anwendet.

Oder eine Art Flipbook mit Vorschauen zu jedem Modell und einem Faktor, der die erwartbare Qualität bewertet.

Antwort von dosaris:

roki100 hat geschrieben:

Wahrscheinlich funktioniert der denoiser ähnlich wie NeatVideo?

augenscheinlich deutlich anders/besser:

Neat hat die üblichen Probleme, dass die Texturen entsprechneder Granularität nach dem Denoisen verschwunden sind.

Die können noise nicht von Textur unterscheiden.

Bei VidEnhance hatt ich schon oft erlebt, dass nach dem denoisen Texturen erscheinen, die man im noise zuvor gar nicht erkennen

konnte.

Nimm mal das Testvideo von NEAT (Autos vor Kreml-Mauer): mit Neat verschwindet die Textur des Busches ziemlich.

Topaz scheint ein intelligentes Object-Tracking beim Interframe-Integrieren zu machen.

Und auch upscaling-Treppen werden gerade gebügelt. dto block-artefakte (aus MPEG2-zeiten)

Erstaunlich

Antwort von roki100:

Ich frage mich ob das genau so gut Moiré verschwinden lässt, wie NeatVideo? Kann das jemand mal testen :)

Antwort von pillepalle:

Hmm... Kein Handbuch, keine Infos. Scheinbar hauptsächlich um murksiges Material zu verbessern. Was für ein Videoformat wird dann in die .mov Datei gepackt? Bei Einzelbildsequenzen gehen vermutlich die Metadaten, Timecode, ect flöten. Ich lad mir das mal spaßeshalber als Testversion runter und probiere aus was für Formate Topaz überhaupt schluckt.

VG

Antwort von Jott:

Kannst du doch selber:

„ Wer prüfen will, ob Video Enhance AI sichtbare Verbesserungen bringt, kann mithilfe einer kostenlosen Trialversion die Funktionen des Programms an den eigenen Videos vor einem Kauf ausprobieren.“

Antwort von pillepalle:

@ Jott

Ja, mache ich ja gerade :) Also in den .mov Container packt er ProRes422HQ und selbige frisst er schon mal. Wer mehr will muss dann Einzelbildsequenzen rendern. Ich glaube es gibt online so eine Art Learn Center und ein Forum, neben dem Support. Hätte einfach gerne vorher mal ein paar Infos dazu gehabt. Aber mit ausprobieren kriegt man ja auch schon das wichtigste heraus.

VG

Antwort von roki100:

also ist jetzt dabei 46 Sekunden Video hoichzuskalieren (von FullHD auf 4K) inkl. Aliasing reducer und steht be 9% seit ca. 15 Minuten... :/

Antwort von cantsin:

Die Denoiser-Ergebnisse sind schon mal exzellent (habe gerade ein älteres Projekt mit GH2-Material im Durchlauf). In der Online-Dokumentation steht auch, dass das Programm bei ProRes-Sicherung größere Farbtiefe speichert, als im Ausgangsmaterial enthalten ist, bzw. dass auch in dieser Hinsicht die KI Information hinzuerfindet.

Antwort von roki100:

Du liebe Güte, diese 9% bedeutet nur 9% Zoom Ansicht ;)))

Zuerst habe ich CDNG File in DR mit CST geschmückt und nichts anderes gemacht...dass dann nach h264 default exportiert (was ja aus DR wirklich schlecht aussieht), das video in KI Tool geladen und rechts (oder links? ;)) ) im Bild das Ergebnis (aktuell wird das noch vorbereitet man kann aber die fertige Frames schonmal betrachten)... Zoom 50%

Bildschirmfoto 2021-02-28 um 19.59.15.png

Antwort von pillepalle:

Ja, da muss man echt mal ein wenig mit herum probieren. Ich habe gerade mal einen Clip auf 8k hochskaliert und sehe da vom Detailreichtum keinen Unterschied, als wenn ich einen 4K Clip in Resolve auf 200% skaliere. Der in Topaz hochskalierte Clip rauscht weniger und der Ton ist nicht mehr da, aber das liegt wohl eher an einem Bedienungsfehler von mir. Der 4K Clip der von Resolve hochskaliert wurde ist aber schärfer. Eine abendfüllende Beschäftigung sich mit den Settings vertraut zu machen :)

VG

Antwort von roki100:

ai ai ai...

Bildschirmfoto 2021-02-28 um 20.16.11.png

Antwort von freezer:

Ich hab jetzt die letzten Tage am Abend viele Stunden mit Testen verbracht.

Das Quellmaterial stammt aus einer professionellen Sony IMX vom ORF und wurde 2006 aufgenommen. Grundsätzlich eine gute Voraussetzung, da diese Kameras eine ordentliche SD-Auflösung hatten (im Gegensatz zu SemiPro-Kameras wie der Canon XM-2). Sony-typisch allerdings auch eine Mördernachschärfung mit Halos von mehreren Pixeln Breite.

720x576 in 50i

Material habe ich per QTGMC deinterlaced -> vorher

Per AviSynth Dehalo und dann weiter durch VEAI geschickt -> nachher

Robert_2_Wetter_no_audio_new.mov_snapshot_00.19.011.jpg

Robert_2_Wetter_no_audio_new_dehalo3_1.00x_768x576_amq-11(1)_1.88x_1920x1080_ghq-5(2).mov_snapshot_00.19.447.jpg

Robert_2_Wetter_no_audio_new.mov_snapshot_00.31.082.jpg

Robert_2_Wetter_no_audio_new_dehalo3_1.00x_768x576_amq-11(1)_1.88x_1920x1080_ghq-5(2).mov_snapshot_00.31.087.jpg

Robert_2_Wetter_no_audio_new.mov_snapshot_00.39.398.jpg

Robert_2_Wetter_no_audio_new_dehalo3_1.00x_768x576_amq-11(1)_1.88x_1920x1080_ghq-5(2).mov_snapshot_00.39.385.jpg

Robert_2_Wetter_no_audio_new.mov_snapshot_01.09.879.jpg

Der links mit dem Toolpack bin übrigens ich vor 15 Jahren und in der Mitte unser Regisseur Stefan Müller.

Robert_2_Wetter_no_audio_new_dehalo3_1.00x_768x576_amq-11(1)_1.88x_1920x1080_ghq-5(2).mov_snapshot_01.09.840.jpg

Robert_2_Wetter_no_audio_new.mov_snapshot_01.17.803.jpg

Robert_2_Wetter_no_audio_new_dehalo3_1.00x_768x576_amq-11(1)_1.88x_1920x1080_ghq-5(2).mov_snapshot_01.17.825.jpg

Antwort von marty_mc:

JA, die 30-tägige Testversion ist schon nette BEschäftigung. Habe mit der 1.9.0 nochmal drei alte Spielfilme (SD) aufpoliert und finde die Ergebnisse schon echt spannend. Vielleicht schaff ich auch endlich das Youtube Video dazu...also gegen Ende der Woche...vielleicht.

Mittlerweile geht auch INTERLACED, das finde ich für ein Dokuprojekt genial und ENDLICH stellt sich bei der Doku nettes High-Def Feeling ein. :-D

Wer will, kann die Software kaufen und unterstützen. Wie gesagt, ein Jahr lang darf man updaten. ANDERERSEITS geht die Entwicklung rasant weiter. Wer noch 3 Jahre wartet, bekommt bestimmt noch wesentlich besseres Ergebniss.

Moiree hat ich bei meinen SD Videos kaum, aber was an Flirren zu sehen war, ging leider nicht weg.

Dafür super: vieles GUT entrauscht. Pixeltreppen glatt gebügelt. Teilweise schon nette "neue" Strukturen bei Haare, Materialien wie Stein, Palmen, Bäume. Kommt halt auf den Modus an. ENDLICH interlaced seit 1.9.0.

Antwort von marty_mc:

Hey FREEZER!

Ja, DAS sieht sehr gut aus, was du gemacht hast! SO gut bekommt das Topaz Video Enhance nicht hin. Vor allem die typischen Kantenanhebungen werden dort nicht weggebügelt.

Welche Programme hast du benutzt? Mir sagen die Abkürzungen nicht alle was. :-)

Grüße!

#martin

Antwort von roki100:

Naja, weiß nicht:

DR + SuperScale + NeatVideo und Sharpen Radius auf 0.47:

Bildschirmfoto 2021-02-28 um 20.41.28.png

Das KI Tool Ding:

Bildschirmfoto 2021-02-28 um 20.42.09.png

KI Ergebnis : Aliasing wird ein bisschen entfernt, dafür aber einige Details völlig weg (schaut z.B. auf Apfel ganz unten links)

Wahrscheinlich funktioniert es besser wenn man VHS/PAL auf höhere Auflösung skaliert, oder 720P zu 1080p. Für den Unterschied wie auf den Bilder, würde ich aber keine 100 Euro ausgeben.

KI Ding habe ich in Mülleimer gepackt. ;)

Antwort von Valentino:

Die Ergebnisse sehen schon echt gut aus, aber gerade beim De-Interlacing, bekommt das der Davinci auch ganz gut hin.

Bei aller Liebe, aber eine Softwarebude die einen "JPEG to RAW Converter" anbietet, wirkt schon etwas unseriös.

Bezweifle auch das da wirklich eine echte KI dahinter steckt. Am Ende ist es einfach ein sehr guter Algorithmus. Von einer KI würde ich z. B. erwarten, das die alle Bilder und Videos der Familie analysiert und daraus lernt und genau dieses Wissen dann in das Up-Scaling bzw. der "Verbesserung" integriert. Alles andere sind für mich entsprechende Algorithmen, die z. B. auf Basis einer Datenbank trainiert wurden. Damit kann der Algorithmus innerhalb der Anwendung nur das Gelernte aber kein neues Wissen integrieren/erlangen und damit ist es dann auch keine echte KI, sondern es wurde nur die Software mit Hilfe von KI entwickelt.

Von echten KI-Andwendungen außerhalb von irgendwelchen Forschungsprojekten sind wir noch mindestens ein Jahrzehnt entfernt. Am Ende werden vorher die Ressourcen knapp und wir haben andere Probleme wie das "Besser-Rechnen" von alten Homevideos ;-)

Antwort von cantsin:

Valentino hat geschrieben:

Von einer KI würde ich z. B. erwarten, das die alle Bilder und Videos der Familie analysiert und daraus lernt und genau dieses Wissen dann in das Up-Scaling bzw. der "Verbesserung" integriert. Alles andere sind für mich entsprechende Algorithmen, die z. B. auf Basis einer Datenbank trainiert wurden. Damit kann der Algorithmus innerhalb der Anwendung nur das Gelernte aber kein neues Wissen integrieren/erlangen und damit ist es dann auch keine echte KI, sondern es wurde nur die Software mit Hilfe von KI entwickelt.

Die Industrie- bzw. Straßen-Definition von KI ist aber schon lange, dass es nicht mehr zwingend um lernende Systeme geht, sondern um Systeme bzw. Datenmodelle, die mit machine learning/deep learning erzeugt wurden (siehe z.B. auch GPT-3 in der Sprach-KI).

Man kann schon sehen, dass Topaz auf Deep Learning und diversen Deep Learning-Modellen basiert, weil er z.B. beim Upscaling von SD-Video Gras-, Haar- und Hautdetails (z.B. mit dem "Gaia High Quality"-Modell) im Bild generiert, die im Ausgangsmaterial nicht vorhanden sind. Sieht man ja auch auf freezers Beispielbildern. Problematisch ist dabei nur, dass diese heuristisch hinzuerfundenen Details nur teilweise im Bild auftauchen und seltsame Bilder entstehen, in denen bestimmte Teile verschwommen sind und andere messerscharf.

Antwort von marty_mc:

cantsin hat geschrieben:

Man kann schon sehen, dass Topaz auf Deep Learning und diversen Deep Learning-Modellen basiert, weil er z.B. beim Upscaling von SD-Video Gras-, Haar- und Hautdetails (z.B. mit dem "Gaia High Quality"-Modell) im Bild generiert, die im Ausgangsmaterial nicht vorhanden sind. Sieht man ja auch auf freezers Beispielbildern. Problematisch ist dabei nur, dass diese heuristisch hinzuerfundenen Details nur teilweise im Bild auftauchen und seltsame Bilder entstehen, in denen bestimmte Teile verschwommen sind und andere messerscharf.

EXAKT!

Der Gaia ist extrem interessant, leider flirrt es mir bei Bewegt-bildern zu sehr, wenn zuviel Korn im Bild ist. Bei WENIG Korn ist es aber schon der Hammer.

Wenn aber Korn im SD bild ist, dann ist der Artemis besser.

Antwort von pillepalle:

Also außer dass das Bild etwas scharf gezeichnet wir und man das rauschen entfernen kann, sehe ich da auch keinen großen Unterschied. Bin mir auch nicht sicher ob mir das besser gefällt. Ist vermutlich wirklich nur gut um Bildfehler wegzubügeln, was beim Reißverschluß aber schon mal nicht geklappt hat.

Ausschnitt eines 4K Originals das in Resolve auf 8K hochskaliert wurde (ohne Superscale). Ohne weitere Bearbeitung wie Schärfen oder Denoisen.

zum Bild

Und der gleiche Ausschnitt der in Topaz auf 8k hochskaliert (Artemis für hohe Qualität) wurde.

zum Bild

VG

Antwort von cantsin:

marty_mc hat geschrieben:

Der Gaia ist extrem interessant, leider flirrt es mir bei Bewegt-bildern zu sehr, wenn zuviel Korn im Bild ist. Bei WENIG Korn ist es aber schon der Hammer.

Wenn aber Korn im SD bild ist, dann ist der Artemis besser.

Man kann auch zwei Durchgänge machen, erst Entrauschen mit Dione und dann Hochskalieren mit Gaia.

@pillepalle, zum Hochskalieren das "Gaia"-Modell verwenden, dann kommen die Texturen bzw. hinzuerfundenen Deep Learning-Bilddetails hinzu.

Antwort von cantsin:

Hier ein Beispiel, eben selbst erstellt aus einer extrem schlechten Quelle (alter Dailymotion-Upload einer 90er Jahre-SD-Channel 4-Doku über die legendäre Exploitationfilmregisseurin Doris Wishman, https://www.dailymotion.com/video/x7v9mau ).

Originalbild (Crop, aus Jugendschutzgründen):

original.JPG

Topaz Video Enhance AI, Gaia-Modell, Hochskalierung auf HD:

topaz-gaia.JPG

Funktioniert leider nicht immer so gut...

EDIT:

Frau Wishman z.B. wird auf diese Weise eher zum Zombie:

vlcsnap-2021-02-28-21h53m45s777.png

vlcsnap-2021-02-28-21h52m31s693.png

Antwort von pillepalle:

Hier das gleiche nochmal mit Gaia. Ist etwas weniger scharf... aber die Out Of Focus Bereiche sehen gruselig aus.

zum Bild

Und das gleiche nochmal mit Resolve Superscale (mit Medium Einstellungen für Schärfe und Denoising). Gefällt mir definitiv besser.

zum Bild

Hier übrigens mal der Originalausschnitt

zum Bild

VG

Antwort von mash_gh4:

cantsin hat geschrieben:

Valentino hat geschrieben:

Von einer KI würde ich z. B. erwarten, das die alle Bilder und Videos der Familie analysiert und daraus lernt und genau dieses Wissen dann in das Up-Scaling bzw. der "Verbesserung" integriert. Alles andere sind für mich entsprechende Algorithmen, die z. B. auf Basis einer Datenbank trainiert wurden. Damit kann der Algorithmus innerhalb der Anwendung nur das Gelernte aber kein neues Wissen integrieren/erlangen und damit ist es dann auch keine echte KI, sondern es wurde nur die Software mit Hilfe von KI entwickelt.

Die Industrie- bzw. Straßen-Definition von KI ist aber schon lange, dass es nicht mehr zwingend um lernende Systeme geht, sondern um Systeme bzw. Datenmodelle, die mit machine learning/deep learning erzeugt wurden (siehe z.B. auch GPT-3 in der Sprach-KI).

naja -- ich sprech in dem zusammenhang auch lieber von "machine learning" statt von KI, weil letzteres immer gleich völlig unangemessene phantasieen evoziert.

es gibt aber in diesem arbeitsfeld auch noch lösungen die quasi zwischen diesem reinen anwenden fertig trainierter modelle und einem erlernen von grund auf angesiedelt sind. das spricht man meist als "transfer learning" an und bezieht sich auf ein vorgehen, wo man die unterste schicht in den trainierten modellen wieder löscht und das ganze mit neuem ausgangsmaterial bezogen auf einen anderen anwendungsfall neu trainiert. auf diese weise kann man mit einem winzigen bruchteil der urspünglichen rechenleistung erstaunlich gute lösungen für ein konkretes problem trainieren, weil das neuronale netz gewissermaßen auf ein riesiges hintergundwissen über abstrakte zusammenhänge zurückgreifen kann, es aber anhand der konkreten neuen lernbeispiele auf einen anderen anwendungsfall überträgt.

derartiges halte ich für die vernünftigste weise, solche techniken praktisch einzusetzen. man bremst damit auch die immanente tendenz solcher systeme, alles auf das selbe schönheits- od. lösungsideal hin auszurichten. das ist ja leider ganz besonders besonders dort, wo es sich nicht nur um hübsche bilder geht, sondern um bewertungen und entscheidungen, die durchaus auch ganz massive praktische soziale auswirkungen haben (bspw. risikoabschätzungen inder versicherungsindustrie u.ä.), immer mehr ein richtiges problem.

leider versucht man halt gegenwärtige die entsprechenden tools für endanwender immer derart simpel zu gestalten, dass sie fast nie irgendwelche vorkehrungen mitbringen, die modelle tatsächlich auch an die eigenen ganz spezifischen bedürfnisse bzw. vorhandenes eigenes lernmaterial anzupassen. damit nimmt sich das ganze meist eher wie ein lustiges und in den ergebnisen überraschendes spielzeug aus, das aber in wahheit weit hinter den tatsächlichen heute relativ einfach verfügbaren möglichkeiten zurück bleibt.

von so dingen, wo entsprechende technik tatsächlich im rahmen der kunst bzw. kreativen zusammenhängen genutzt wird, und tatsächlich mit so etwas wie "assoziationen" od. visuellen eindrücken "spielt", rede ich lieber gar nicht. da gibt's bisher leider ohnehin nur sehr wenig, das wirklich beeindruckt.

Antwort von roki100:

mit dem Tool wird ffmpeg installiert. Scheint also irgendwie damit zu funktionieren und der Entwickler dachte sich wohl, einfach ne GUI bauen und 100 Euro verlangen...?

Antwort von cantsin:

roki100 hat geschrieben:

mit dem Tool wird ffmpeg installiert. Scheint also irgendwie damit zu funktionieren und der Entwickler dachte sich wohl, einfach ne GUI bauen und 100 Euro verlangen...

Nein. ffmpeg wird nur als Encoder/Decoder verwendet. Diese Upscaling- und Bildverbesserungsalgorithmen gibt es in ffmpeg selbst nicht.

Antwort von freezer:

marty_mc hat geschrieben:

Hey FREEZER!

Ja, DAS sieht sehr gut aus, was du gemacht hast! SO gut bekommt das Topaz Video Enhance nicht hin. Vor allem die typischen Kantenanhebungen werden dort nicht weggebügelt.

Welche Programme hast du benutzt? Mir sagen die Abkürzungen nicht alle was. :-)

Grüße!

#martin

Doch, doch, das neue Artemis Medium Quality v11 Modell kann Kantenanhebung nun wegrechnen.

Es ist aber wie bei vielen Filterspielereien ein Herumprobieren was wie in welcher Reihenfolge funktioniert.

Bei den Beispielen nutze ich zuerst StaxRip mit Videofiltern aus der freien AviSynth-Szene (doom9.org). Der meiner Meinung nach beste Deinterlacer ist der AviSynthfilter QTGMC. Dann folgen 2 Filter zum Verringern der Halos.

Anschließend ein Durchlauf im Video Enhance AI 2 mit dem Artemis Medium Quality bei 100% Skalierung, das filtert den Rest der Halos weg.

Dann ein Hochskalieren mit Gaia HQ auf 1920x1080.

Bei anderen Quellen muss man wieder andere Ansätze finden. Einfach draufklatschen ist nicht.

Antwort von marty_mc:

freezer hat geschrieben:

Doch, doch, das neue Artemis Medium Quality v11 Modell kann Kantenanhebung nun wegrechnen.

OK, Cool! Muss ich mal ausprobieren

Antwort von marty_mc:

freezer hat geschrieben:

Anschließend ein Durchlauf im Video Enhance AI 2 mit dem Artemis Medium Quality bei 100% Skalierung, das filtert den Rest der Halos weg.

Dann ein Hochskalieren mit Gaia HQ auf 1920x1080.

Hey Freezer°

DEIN TIPP macht echt was her. Denn Gaia ist macht tolle Ergebnisse, wenn das Ausgangsmaterial NICHT rauscht. Leider rauscht es meistens und ich konnte es deshalb nie nehmen, weil es immer Passagen gibt, die rauschen und ich will den Film durchrechnen lassen und nicht alles segmentieren.

Es ist also nur logisch, das Material zu deblocken und denoisen (artemis Modus Medium) und TATSÄCHLICH gehen die digitalen Kantenanhebungen mit dem Artemis Medium Modus FAST weg. SUPER!

Wenn man DANN den Gaia (aktuell Version5) raufpackt, macht das echt war her. Ist zwar nicht knackig scharf, aber SEHR FILMISCH, gefällt mir sehr.

Ich werd die Tage das mal für ne Filmsequenz rausrechnen und mir an meinem TV anschauen, ob ich das nochmal mit nem eigenen Film mache.

Danke, Danke, Danke!!!

Martin

Antwort von marty_mc:

Ich hab mal 2 Fragen:

1. WO kann man bei der neuen 2.0 Version den Speicherpfad wählen?? Bei mir werden die fertig gerenderten Bilder oder Videos am Ort des Rohmaterials abgelegt.

2. Die Idee den SD Film erst mit Artemis 11 Medium in SD zu rendern und danach mit Gaia 5.0, finde ich super. ABER, in welcher File Art könnte man das Zwischenvideo rendern? Für mich geht aktuell nur ProResHQ. Ich würde gern jpg 8bit compressed nehmen, um minimale Verluste zu haben. ABER eine jpg Sequenz kann ich nicht mehr in Topaz reinladen. Ich müsste die Sequenz vorher nochmal (in Prem) rendern. Ist mir aber zu aufwendig und ich will nicht zu viele Zwischenvideos rendern. Das wirkt sich unvorteilhaft für Gaia aus.

Antwort von dosaris:

marty_mc hat geschrieben:

1. WO kann man bei der neuen 2.0 Version den Speicherpfad wählen?? Bei mir werden die fertig gerenderten Bilder oder Videos am Ort des Rohmaterials abgelegt.

rechts unten hinter out

Antwort von marty_mc:

dosaris hat geschrieben:

marty_mc hat geschrieben:

1. WO kann man bei der neuen 2.0 Version den Speicherpfad wählen?? Bei mir werden die fertig gerenderten Bilder oder Videos am Ort des Rohmaterials abgelegt.

rechts unten hinter out

Autsch...DANKE! :-)

Antwort von cantsin:

marty_mc hat geschrieben:

2. Die Idee den SD Film erst mit Artemis 11 Medium in SD zu rendern und danach mit Gaia 5.0, finde ich super. ABER, in welcher File Art könnte man das Zwischenvideo rendern? Für mich geht aktuell nur ProResHQ. Ich würde gern jpg 8bit compressed nehmen, um minimale Verluste zu haben.

Mit ProRes HQ hast Du deutlich weniger Qualitäts-/Informationsverlust als mit JPEG 8bit...

Antwort von marty_mc:

cantsin hat geschrieben:

marty_mc hat geschrieben:

2. Die Idee den SD Film erst mit Artemis 11 Medium in SD zu rendern und danach mit Gaia 5.0, finde ich super. ABER, in welcher File Art könnte man das Zwischenvideo rendern? Für mich geht aktuell nur ProResHQ. Ich würde gern jpg 8bit compressed nehmen, um minimale Verluste zu haben.

Mit ProRes HQ hast Du deutlich weniger Qualitäts-/Informationsverlust als mit JPEG 8bit...

Danke.

Ok, mit Ausnahme von 8K, da funktioniert ProRes nicht mehr.

Antwort von Jott:

Natürlich funktioniert ProRes in 8K. Mache ich oft (für 360 Grad-Sachen).

Antwort von marty_mc:

Jott hat geschrieben:

Natürlich funktioniert ProRes in 8K. Mache ich oft (für 360 Grad-Sachen).

Hm, aber nicht in Topaz, zumindest mit der 1.9.0 Version. Für die 2.0 kanns ichs grad nicht sagen, da renderts grad.

Antwort von Jott:

Weiß ich nicht. Ich dachte, du meinst prinzipiell.

Antwort von marty_mc:

Noch ne Frage an euch: KENNT ihr das Problem, das normales SD Material (720x576 und 50i) plötzlich alle 25 Sekunden ein Doppelbild enthält?

Also es kommt z.B. Frame Nummer 18, dann 19, dann 20, dann nochmal 20 und dann Frame Nummer 22. Also ein Frame wird alle 25 Bilder übersprungen.

DAS Problem habe ich aber nur bei einem Film Master. Und damals mit der Version 1.0.0 hatte ich DAS Problem nicht gehabt. Erst jetzt mit 1.9.0 und jetzt mit 2.0.

Wer hat ne Idee?

Danke & Gruß!!

Martin

Antwort von freezer:

Schein ein Bug zu sein. Ich hab sowas ähnliches dem Entwickler auch schon gemeldet und Beispielfootage hochgeladen. Sie arbeiten an der Behebung für das nächste Update.

Wann das kommt wurde aber nicht gesagt.

Antwort von markusG:

Hm...ich krieg's nicht zum laufen :( ich kann nach dem reinladen eines Videos weder den Algorithmus auswählen (ist einfach leer), noch funktioniert die Vorschau oder gar das Processing (lädt sich tot).

Das ganze im Trial-Modus, mit eingeloggtem Account. Grafikkarte (Nvidia) wird auch korrekt erkannt (Treiber sind aktuell). Hat jemand einen Tipp?

Antwort von dosaris:

marty_mc hat geschrieben:

...KENNT ihr das Problem, das normales SD Material (720x576 und 50i) plötzlich alle 25 Sekunden ein Doppelbild enthält?

Also es kommt z.B. Frame Nummer 18, dann 19, dann 20, dann nochmal 20 und dann Frame Nummer 22. Also ein Frame wird alle 25 Bilder übersprungen.

DAS Problem habe ich aber nur bei einem Film Master. Und damals mit der Version 1.0.0 hatte ich DAS Problem nicht gehabt. Erst jetzt mit 1.9.0 und jetzt mit 2.0.

was für'n Input- (MPEG2?) u output-Format (Verpackung, AV etc)?

gerade nochmal getestet:

hab ich noch nicht beobachtet, weder bei 2.0 noch vorher

Antwort von marty_mc:

dosaris hat geschrieben:

marty_mc hat geschrieben:

...KENNT ihr das Problem, das normales SD Material (720x576 und 50i) plötzlich alle 25 Sekunden ein Doppelbild enthält?

Also es kommt z.B. Frame Nummer 18, dann 19, dann 20, dann nochmal 20 und dann Frame Nummer 22. Also ein Frame wird alle 25 Bilder übersprungen.

DAS Problem habe ich aber nur bei einem Film Master. Und damals mit der Version 1.0.0 hatte ich DAS Problem nicht gehabt. Erst jetzt mit 1.9.0 und jetzt mit 2.0.

was für'n Input- (MPEG2?) u output-Format (Verpackung, AV etc)?

gerade nochmal getestet:

hab ich noch nicht beobachtet, weder bei 2.0 noch vorher

Das File im Rechner stammt vom miniDV Band.

ABER wie gesagt, ich habe auch ein anderes Master vom miniDV Band, welches das Problem nicht zeigt. Daher bin ich auch ratlos. OK, ich könnte das DV File in etwas anderes in Premiere wandeln. DAS ist das einzige, was ich probieren könnte.

Was empfehlt ihr da?

Ich hab nur nicht so viel Lust auf diese Methode, da jedes Mal "wandeln" minimale Verluste bringen, die sich auch auf das Endfile mit Topaz leicht negativ auswirken.

Und ne TIFF Sequenz kannst du nicht in Topaz importieren.

Antwort von cantsin:

marty_mc hat geschrieben:

ABER wie gesagt, ich habe auch ein anderes Master vom miniDV Band, welches das Problem nicht zeigt. Daher bin ich auch ratlos. OK, ich könnte das DV File in etwas anderes in Premiere wandeln. DAS ist das einzige, was ich probieren könnte.

Was empfehlt ihr da?

ProRes. Kannst Du auch mit Shutter Encoder (Open Source) erzeugen.

Antwort von MK:

marty_mc hat geschrieben:

Und ne TIFF Sequenz kannst du nicht in Topaz importieren.

Natürlich geht das... schau Dir beim Öffnen die Dropdown-Box neben dem Feld Dateiname nochmal an...

Antwort von marty_mc:

cantsin hat geschrieben:

marty_mc hat geschrieben:

ABER wie gesagt, ich habe auch ein anderes Master vom miniDV Band, welches das Problem nicht zeigt. Daher bin ich auch ratlos. OK, ich könnte das DV File in etwas anderes in Premiere wandeln. DAS ist das einzige, was ich probieren könnte.

Was empfehlt ihr da?

ProRes. Kannst Du auch mit Shutter Encoder (Open Source) erzeugen.

Danke! SO geht es tatsächlich. Ich hab mich für ProRes444 in Premiere entschieden und das "Doppelframe" ist nun erstmal weg.

Antwort von marty_mc:

Und jetzt nochmal ne Korrektur von meiner Seite: Der ProRes 444 funktionierte nur mit meinem 20 sekündigem Testclip. Sobald man das miniDV Master zum ProRes444 wandelt (82min Film und ca. 44Gb dann) und DANN in Topaz reinladen will, stürzt das Programm ab. Auch mit ProResHQ.

Einzig erfolgreich war der normale ProRes UND ich habe den Film in 2 Hälften teilen müssen (10 und 11Gb jedes File). Dann lassen sich beide Files in Topaz reinladen, aber man muss trotzdem ca. 5 Minuten warten.

VIELLEICHT hätt ich beim ProRes HQ auch nur 30min warten müssen. Aber es passiert einfach nix und wenn man dann irgendwo in die Oberfläche klickt kommt "keine Rückmeldung" und Absturz den Programms.

Antwort von Jott:

Unabhängig von diesem Phänomen ist alles über normalem ProRes totaler Overkill für eine DV-Quelle.

Antwort von marty_mc:

Jott hat geschrieben:

Unabhängig von diesem Phänomen ist alles über normalem ProRes totaler Overkill für eine DV-Quelle.

:-D Wahrscheinlich. Aber sicher ist sicher. ;-)

Antwort von marty_mc:

So Leute, meine bisherigen Erfahrungen habe ich in dem Video zusammen gefasst. Lasst uns auf dem neuesten Stand bleiben, wer bessere Erfahrungen gemacht hat mit neueren Versionen von Topaz Video, einfach hier Bescheid sagen!

Hier mein Video:

Viel Spaß euch!

Martin

Antwort von r.p.television:

marty_mc hat geschrieben:

So Leute, meine bisherigen Erfahrungen habe ich in dem Video zusammen gefasst. Lasst uns auf dem neuesten Stand bleiben, wer bessere Erfahrungen gemacht hat mit neueren Versionen von Topaz Video, einfach hier Bescheid sagen!

Hier mein Video:

Viel Spaß euch!

Martin

Danke für Deine Eindrücke. Ich habe mich nach langem Testen für den Gaia HQ-Modus entschieden. Auch wenn der das Rauschen nicht so wegbügelt, aber der Artemis macht mir manchmal zu komische Detailanhebungen. Vorallem im Hintergrund, wo ich die Details gar nicht so haben will und wo sie teilweise sogar schon im unfokusierten Bereich waren.

Ich habe bisher aber kaum SD zu HD hochskaliert, sondern Full HD nach etwa 6k, um es in der Timeline wieder auf 4k runterzubrechen.

Die Ergebnisse finde ich gut bis verwirrend. Gerade das frühe SD-Material meiner FS700 gewinnt dabei kaum, weil sie relativ weich gezeichnet hat. Das elektronische Bild von Consumerkameras dagegen gewinnt überraschend an Schärfe. Aber ich betone hier Schärfe, denn die Kantenüberzeichnung wird dabei einfach auch nochmal hochgerechnet und die Kanten verstärkt. Dabei aber von den Treppchen bereinigt. Aber wirklich mehr Details sehe ich selten. Aber der subjektive Schärfeeindruck ist verbessert.

Wirklich cool wird es mit alten Masterfiles, die noch interlaced von DVCAM kommen. Da sind die Unterschiede wirklich enorm und verblüffend.

Antwort von medienonkel:

Mich stört an der aktuellen Version bei der Dione, dass aus den 50 Halbbildern auch 50 Vollbilder ausgegeben werden.

Ist zwar technisch korrekt, verdoppelt aber leider natürlich die Rechenzeit. Da wäre eine Option, auch 25 Bilder wählen zu können schon nicht schlecht.

Ich experimentiere momentan mit DV, S-VHS und Video 8 Material ein wenig herum. (20 Stunden unterschiedlichstes Material)

Leider nur teilweise mit TBC eingespielt.

Deinterlaced wird mit DaVinci im High Mode. Die Neural Engine rechnet mir da tatsächlich zu lange herum bei kaum sichtbaren Unterschieden zum High Modus.

Und dann je nach Material mit Artemis (M oder L) hoch auf 8K. Das 8K File kommt dann in eine UHD Timeline, wird vom underscan befreit, Materialabhängig deflickert, evtl. Weißableich angepasst und dann in DNxHD rausgerendert.

Zielauflösung sind ganz schnödes 1080p.

Die UHD nutze ich dann nur noch zur Stabilisierung bzw. zum reframing auf 16:9.

Die teilweise kuriosen Details, die die Software reinrechnet verspielen sich so ganz gut.

Aliasing verrechnet sich auch ganz angenehm, wenn man z.B. einen Mitchell nimmt.

Manchmal wandern Bartstoppeln an die Stelle von Sommersprossen...

Dann unbedingt noch Korn drauf, um wieder Struktur ins doch oft sehr weich gebügelte Bild zu bekommen.

Die Ergebnisse sind gemischt und es ist natürlich sehr vom Material abhängig, ob der Weg über die 8K wirklich sinnvoll ist. Meistens nicht. Man weiß es aber erst hinterher, also wieso nicht.

Wenn es darum geht sehr feine Schrift z.B. auf Verpackungen noch lesbar zu halten ist der Weg über das Dione Netz und internes Deinterlacing bei manchen Bildern der Bessere Weg.

Antwort von marty_mc:

medienonkel hat geschrieben:

Mich stört an der aktuellen Version bei der Dione, dass aus den 50 Halbbildern auch 50 Vollbilder ausgegeben werden.

Ist zwar technisch korrekt, verdoppelt aber leider natürlich die Rechenzeit. Da wäre eine Option, auch 25 Bilder wählen zu können schon nicht schlecht.

Aber es gibt doch 3 Interlace Modis und der erste berechnet dir die Halbbilder zu Vollbider. Da ich aber den 50i Look beibehalten wollte, hatte ich den nicht weiter getestet.

Stimmt! Die doppelte Rednerzeit darf man bei 50i zu 50p nicht unterschätzen!!!

Antwort von medienonkel:

marty_mc hat geschrieben:

Aber es gibt doch 3 Interlace Modis und der erste berechnet dir die Halbbilder zu Vollbider. Da ich aber den 50i Look beibehalten wollte, hatte ich den nicht weiter getestet.

Stimmt! Die doppelte Rednerzeit darf man bei 50i zu 50p nicht unterschätzen!!!

Och, gegen doppelte Rednerzeit hab ich nie was ;-)

Was meinst du mit dem 50i look?

Ich frage nur, weil ich schon Leute erlebt habe, die den Interweave- oder auch Kammeffekt nicht als Fehler wahrgenommen haben. Und das trotz extra angeschlossener Röhre, um zu sehen, dass was nicht stimmt ;-)