Aus Erfahrung einfach spinnen lassen?

Eine aktuelle (Zwischen?)-Lösung liegt darin, dem KI-Modell als Ausgangsmaterial ein fertiges Bild zu präsentieren und es dann daraus eine (höchstens offen) formulierte Bewegung weiterspinnen zu lassen. Trainiert werden solche Modelle mit sehr unterschiedlichen Bewegtbild-Daten, bei denen man vorhandene Frames in Videoclips auslässt und diese durch ein Netz mit dem echten Zwischenbild als Zielausgabe trainiert. Dies kann man sich wie die Restauration eines fehlenden Frames vorstellen.

Bewegung ohne Ziel

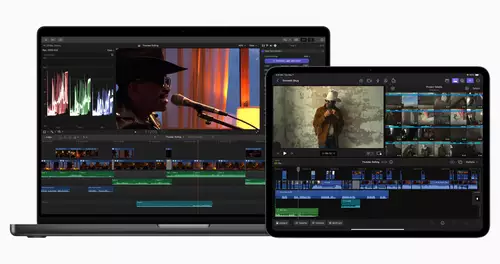

Nvidia nutzt diese Idee übrigens sehr erfolgreich, um bei Videospielen die Frameraten zu erhöhen, indem man fehlende Zwischenbilder in Echtzeit hinzu erfindet. Noch spannender ist es jedoch mittlerweile, das KI-Modell von einem Bild einfach selbständig losspinnen zu lassen. Also ohne ein festes Zielframe.

Aktuelle Beispiele

Im einfachsten Fall kann man -wie in unserem Mattepainting-Workshop oder bei den viralen Wes Anderson Clips- von der KI ein relativ einfaches, statisches Umfeld erschaffen lassen und Teilbewegungen in den Clip integrieren. Vor wenigen Tagen wurde beispielsweise ein neues Black Eyed Peas Musikvideo vorgestellt, welches sich offensichtlich zumindest teilweise dieser Technik bedient:

Mit neueren Tools wie Pika Labs kommt nun aber echtes Leben in die Bude. Hierbei können aus beliebigen Standbildern mittlerweile mehrere Sekunden Video weitergesponnen werden. Jetzt sogar inklusive der Bewegung von Objekten im ganzen Bild sowie Kamerafahrten. Ein erstaunliches Beispiel zum Stand der Technik liefert das zugegebenermaßen recht unappetitliche Video "Mucky Run" von douggy:

Da hier sowieso alles schleimt und glibbert, fallen die entsprechenden KI-Bewegungs-Artefakte nicht auf, sondern werden passend vom Thema selbst maskiert.

Mit ähnlichen Tricks kaschiert auch "Star Wars 2023" die eigentlich noch stark eingeschränkten Möglichkeiten von Pika Labs. Es gibt nur wenige Sekunden Clip am Stück und der Inhalt ist nicht so vertraut, dass das Bewusstsein jeden Bildfehler gleich ablehnt:

Sogar im Gegenteil: Hält man das Video an, sieht man in den Standbildern erstaunlich viele Fehler, die jedoch aufgrund der Fixierung auf die Bewegung beim ersten Sehen nicht unbedingt wahrgenommen werden.